PolifonIA.org | Carlos Macías. Los retos que esperan a México en el espacio de la Supercomputación son enormes. Empecemos por señalar que, en el presente año de 2025, nuestro país no figura en la lista Top500, que es la más reconocida del segmento.

Vale señalar que la lista Top 500 se publica desde 1993.

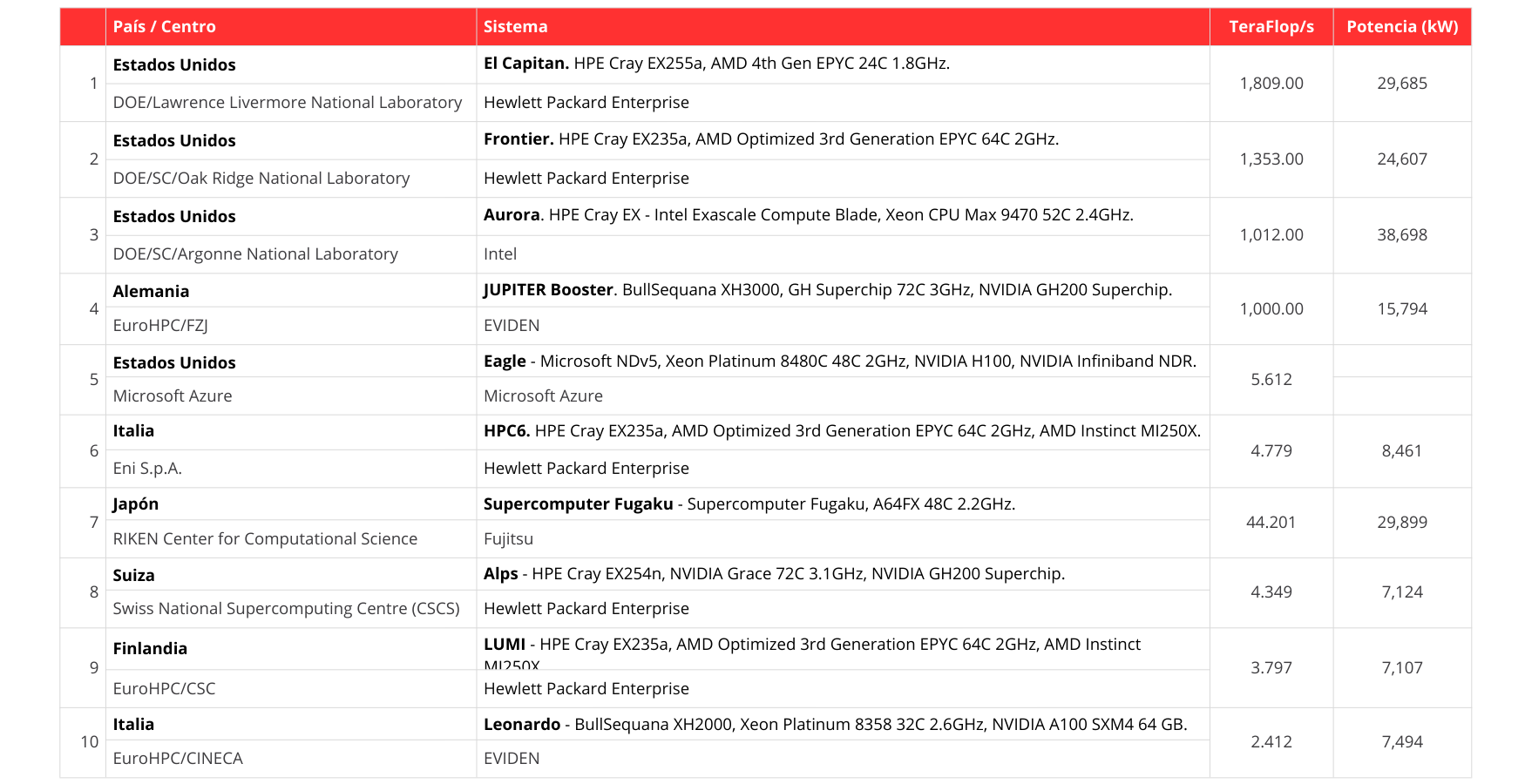

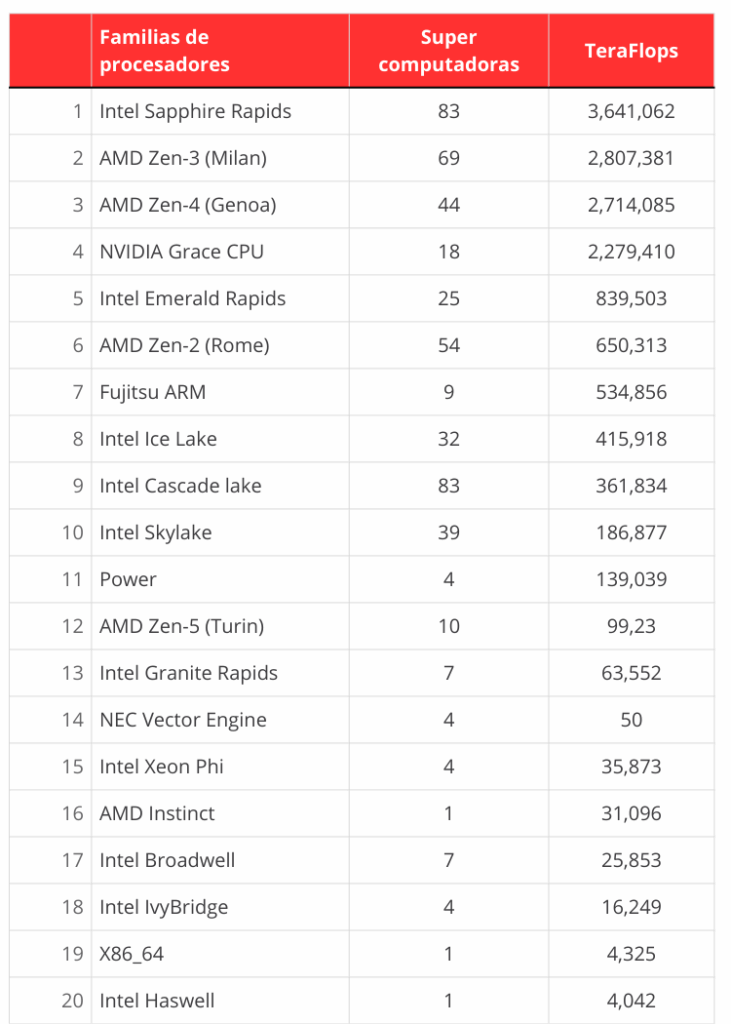

Presentamos abajo las características del Top 500. Sus resultados y las conclusiones que se extraen del reporte de noviembre de 2025.

Por lo pronto, nos apresuramos a plantear algunas ideas de contexto.

La IA: ni novedosa, ni unidireccional

La más afortunada visión acerca de la Inteligencia Artifical, es la que suele buscarle una razonable articulación, dentro del conjunto revuelto del que ha emergido. Piezas o componentes fragmentarios de naturaleza tecnológica, financiera, corporativa, política y cultural.

El desarrollo de la Inteligencia Artifical no debe verse como una oleada novedosa, ni unidireccional. La componen múltiples orígenes, fuerzas y cauces.

Nos referimos a esas piezas o productos derivados de la tecnología que, con el tiempo, pueden lograr permanencia en la vida cotidiana de las personas, por su usabilidad.

Son las piezas visibles y/o veladas, dentro de un todo, que provienen de la innovación. Pero también de las decisiones corporativas y financieras, de las prioridades de políticias nacionales y, desde luego, de la cultura de las comunidades.

Las comunidades son quienes, finalmente, asumen una conducta de acompañamiento, —o de renuencia—, ante las propuestas de innovación y, en su caso, ante la ruta de continuidad tecnológica.

El componente imprescindible de la Inteligencia Artificial

Cuando hablamos del flanco de producción tecnológica de la Inteligencia Artifical, sin duda aludimos a múltiples partes, no sólo semiconductores (que son lo más visible desde 2023).

El componente más importante de la inteligencia artificial, para expresarlo en forma resumida, proviene de la pluriculturalidady el multilingüismo.

El caudal que proveen dichos componentes (el cúmulo heredado y el razonamiento que lo acompaña) otorga sentido a la arquitectura de cada aplicación.

Ese caudal también otorga sentido al formato más empleado (LLM o multimodal), a los asistentes, agentes y agencias. También a la orientación que adopta cada lenguaje de programación.

La pluriculturalidady el multilingüismo han contribuido, su vez, en el procesamiento del lenguaje natural y -lo hacen con mayor vigor cada día- en el lenguaje generativo.

La omniprescencia de la herencia pluricultural y multilingüística también ha contribuido y contribuye en el acopio de materias primas para el hardware. Y, en especial, en los contenidos centrales del procesamiento de la información.

Lo han hecho en la propia cualidad generativa y en la pretensión social de expansión de la Inteligencia Artificial, casi generalizada.

En suma, las coordenadas que ofrecen lo cultural y lo lingüístico están presentes hasta en los términos en que se escriben y se renuevan los lenguajes de programación.

Otros componentes de la Inteligencia Artificial

Desde luego, también forman parte de la IA todas aquellas piezas que conforman la infraestructura física y la estructura generada:

- Lenguajes de programación;

- Semiconductores;

- Procesos de litografía en semiconductores;

- Centros de datos;

- Procesamiento de lenguaje natural;

- Arquitectura de aplicaciones (asistentes, agentes, chats);

- Computación de alto rendimiento (supercomputación);

- Habilidades humanas, que articulan todo lo anterior y nutren de contenidos e ideas a cada lenguaje de programación, sea Phyton, C++, Haskell o JavaScript;

- Financiamiento y especulación;

- Ideas de marco normativo en ciernes;

- Gobernanza IA;

- Frontera artificial de la inteligencia humana (AI general).

¿Qué política nacional tecnológica se debe impulsar?

La decisión más inteligente para los países sería impulsar una política pública que se acerque lo más posible a la tendencia y a la lectura correcta del ambiente y de la transformación tecnológica y cultural global.

El mayor reto para México, cuando se habla de proyectos de incorporación tecnológica, radica en asegurarse que las decisiones que se adopten puedan llegar a fructificar. En especial ante condiciones caracterizadas por recursos económicos exiguos.

Cuando señalamos tomar decisiones que puedan fructificar, nos referimos a la mejora de la infraestructura y de la base tecnológica.

En particular, del impulso sostenido de una política de formación y fomento científico y tecnológico con cobertura nacional. Que incluya la participación planificada de actores públicos y privados, con horizonte de mediano y largo plazo.

Pero también al esfuerzo permanente por la mejora medible de los servicios públicos, de la educación y de la investigación científica y tecnológica.

A juzgar por los datos disponibles, hoy los países emergentes no parecen estar seducidos por la idea de invertir sus escasos recursos en competir con los grandes corporativos.

Los emergentes buscan una inserción redituable, no ensayos de protagonismo

A los países emergentes de la década de 2020-2030 ya no parece apetecerles iniciar desde cero. No parece pertinente incursionar de modo épico en aquellos nichos tecnológicos que son de predominio y vocación añosa de las empresas que ya están perfiladas a nivel global. Es el caso de los semiconductores.

Los corporativos y los países líderes llevan décadas generando condiciones. Fomentan infraestructura, innovación y procesos de producción, que los ha llevado a dominar el nicho tecnológico que han agenciado.

Incluso, hoy la coinversión alemana-holandesa (Bosch, Infineon y NXP) con la experimentada taiwanesa de semiconductores (TSMC) parece enfrentar problemas para iniciar la fase de producción proyectada. Aún con la subvención de la Comisión Europea.

Tomaremos el ejemplo de los datos actualizados a noviembre de 2025, difundidos por la reconocida firma Top500.

Resultados Top500 de Supercomputación, 2025

Tres laboratorios estadounidenses adscritos al Departamento de Energía (y uno adicional, de Microsoft) forman parte de las 10 primeras supercomputadoras del mundo.

A esos cuatro centros estadounidenses del Top 10, se agregan otros 161, con supercomputadoras. Éstos se encuentran distribuidos en ese país, y permanecen en el Top 500.

Para 2026, el gobierno de Estados Unidos ha programado un presupuesto de 150 mil millones de dólares para sus 10 laboratorios públicos. Un descenso desde los 200 mil, de años previos. Dependen del Departamento de Energía.

Reciben presupuesto complementario del National Nuclear Security Administration (NNSA) y de otros Strategic Partnership Projects (SPP).

Están alineados con el Programa nacional llamado “Ciberseguridad, seguridad energética y respuesta a emergencias“.

¿Qué laboratorio encabeza la lista?

La lista global la encabeza el Laboratorio Nacional Lawrence Livermore. Ahí se alberga la supercomputadora el Capitan, en California.

El laboratorio fue creado durante la Guerra fría, en 1952, como centro de investigación. Se enfocó en reforzar la seguridad nacional, mediante el estudio de la tecnología de las armas nucleares.

El Capitán, equipado con HPE y AMD, alcanza 1.809 exaFlops (es decir, 1,809 petaFlops). Véase nuestra nota anterior, respecto a su capacidad comparativa.

Top 10 del Top 500

¿Quiénes destacan en supercomputación en América Latina?

En el Top 500, sólo figuran Brasil (con siete supercomputadoras) y Argentina (con una).

Por parte de Brasil, Pegaso es la de mayor capacidad (en el lugar 33), Harpía (36), Dragao (46), Atlas (56), Gaia (93), Fénix (142) y Geminis (165).

No es casual que las siete supercomputadoras de Brasil pertenezcan a la estatal Petroleo Brasileiro (Petrobras). Estan dedicadas en lo esencial a gestión, plantación de combustible (gasóleo), predicciones de clima y prospección, en esencia.

Argentina posee una meritoria supercomputadora llamada Clementina XXI. Fue inaugurada hace algunos meses en las instalaciones del Servicio Meteorológico Nacional. Ocupa el lugar 195 del mundo.

Forma del Sistema Nacional de Cómputo de Alto Desempeño (SNCAD). Cuenta con una Comisión de Gobernanza. En ésta figuran expertos de la Red Nacional de Centros de Cómputo de Alto Desempeño. Además de la Comisión Nacional de Energía Atómica y del CONICET.

¿Tiene sentido apostar por la Supercomputación en México, con Coatlicue?

Absloutamente. En una nota anterior expresamos nuestra opinión al respecto. Los esfuerzos anteriores en nuestro país ahora parecen haberse quedado a la zaga.

Miztli, de la UNAM, que inició en 2013, tiene una capacidad de procesamiento de 228 teraFlops, y se ubica por abajo del Top 500.

En fecha reciente, el área de Cómputo de Alto Rendimiento de la Universidad de Sonora puso en funcionamiento la supercomputadora Yuca.

Yuca es hoy la de mayor capacidad en nuestro país. Alcanza, de acuerdo con una fuente, dos mil 300 teraflops y, de acuerdo con otra, más de dos petaFlops.

Hace tiempo que la mesa (de semiconductores) está puesta: alto desempeño vs. usuario final

Se apreciará que no figuran en la lista Top 500 aquellos fabricantes de procesadores que son reconocidos líderes en el mercado de chips.

Se trata de aquellas compañías que se mueven en la esfera de los dispositivos móviles y los procesos de manufactura, del uso automotor, por ejemplo. También de lo que podríamos denominar internet de las cosas. Esos fabricantes, de nicho consolidado, empleados en los equipos que nos acompañan en la vida cotidiana, no están en el Top 500.

Nos referimos a corporativos de países que proveen semiconductores en otra escala, muy distinta al alto desempeño. Pero que su contribución resulta fundamental en la vida cotidiana de todas las personas en el mundo.

Son los casos de Taiwan (MediateK y TSMC, que fabrican chips para las estadounidenses NVIDIA, AMD y Apple), de Estados Unidos (Qualcomm), de Corea del Sur (Samsung) y de China (Xiaomi), entre los más representativos.

Los límites del patrocinio estatal en Supercomputación

En todos esos casos puede aparecer cierto fomento estatal. Pero el desarrollo, la innovación y el papel fundamental corre por cuenta de corporativos privados. A ellos se unen grupos de investigación e instituciones. Con predisposición abierta y comprometidas con el largo plazo, orientadas a la innovación tecnológica. El caso de China viene a ser, en nuestro tiempo, un buen ejemplo de ello.

Sobra ejemplificar que el patrocinio y el fuerte impulso que el Estado chino ha dado al desarrollo de semiconductores. En particular desde 2024. Ello se ha traducido en diversos fondos de inversión, subsidios y créditos fiscales a las empresas que despliegan proyectos desde su incubación.

Los tres dominantes

Existe en la actualidad un despliegue de compañías chinas en segmentos específicos de semiconductores. Pero son los actores corporativos conocidos y dominantes, los que alimentan las necesidades de la computación de alto rendimiento. Es decir, las necesidades de la supercomputación.

Son compañías privadas de Estados Unidos y de Japón. O de Estados Unidos, Taiwan, Corea del Sur y China, si lo hacemos extensivo a los productores de chips a escala menor, para el usuario final.

(En un texto previo hablamos de una notable excepción, en litografía y luminosidad necesarias para la creación de semiconductores: la holandesa ASML).

En particular, en cuanto a la computación de alto rendimiento, hace tiempo ha estado la mesa puesta para las compañias. Las estadounidenses (NVIDIA, Intel y AMD), las japonesas (NEC y Fujitsu), además de la china Lenovo, que adquirió la división de computación de IBM en 2005.

Las siete magníficas

En últimas fechas, con Gemini 3 de Google, nos ha quedado claro que incluso aquellos actores dominantes de la tecnología conocidos como “las 7 magníficas”. Están llamados a incursionar con fuerza en AI.

Nos referimos a Alphabet -Google-, Amazon, Apple, Meta -Facebook-, Microsoft, NVIDIA y Tesla.

Estas siete magníficas tienen experiencia, dominancia y vocación en la oferta de servicios integrales. Podrían encabezar con mucha ventaja la carrera dentro de los servicios inminentes de IA.

El ejemplo ya lo dio Google en el pasado noviembre, cuando se aprecia que hizo acopio de las Unidades de Procesamiento de Tensores (TPU).

Las TPU son una modalidad evolucionada de las ASIC que referimos en otra nota anterior, para dejar atrás con facilidad a ChatGPT.

Quizá por experiencia personal, tú también lector, ahora estás más tentado a dirigirte cada vez más al amigable buscador de Google con AI. Así te ahorras preguntarle al chat en tu cuenta o en tu aplicación.

Como sabemos, el término de “las siete magnificas” (mujeres) está tomado de la película que inauguró el género conocido como spaghetti western, y que fue una coproducción europea (1960).

Ahora sí, vamos a la caracterización del índice.

¿Qué es la Top 500?

Esta clasificación inició al retomar la experiencia del doctor Hans Meuer, de la Universidad de Mannheim, Alemania. Desde 1986 había sistematizado la información acerca de los modelos de distintos equipos de cálculo de alto desempeño en el mundo.

A partir de 1993, el equipo de Hans Meuer se amplió y fue creado el Top 500.

Se sumaron a su directorio los siguientes especialistas:

- Erich Strohmaier, del NERSC/Lawrence Berkeley National Laboratory;

- Jack Dongarra, de la Universidad de Tennessee, Knoxville;

- Horst Simon, del NERSC/Lawrence Berkeley National Laboratory; y

- Martin Meuer, de Prometeus.

Aunque el fundador Hans Meuer falleció en 2014, el resto de la membresía se conserva como en 1993.

La lista Top 500 se basa en la sistematización de datos sobre las supercomputadoras en el mundo.

Mide el rendimiento de éstas, los sistemas de procesamiento y la potencia de su cálculo, por estación de trabajo o laboratorio.

¿Con qué periodicidad se publica la lista mundial en Supercomputación?

Dos veces al año, una en junio y otra en noviembre, desde 1993.

¿Qué constantes permanecen en el largo periodo de 1993 a 2025?

La primera ocasión que el listado de TOP 500 fue publicado, en 1993, ocho laboratorios estadounidenses figuraron entre los 10 primeros lugares. La tendencia permanece.

Otra constante: los insumos de CPU y GPU (para computación de alto rendimiento) son producidos por compañías privadas.

En cambio, los laboratorios que albergan la supercomputación son de caracter público. Están ligados a sectores diversos: seguridad, energías, predicciones, clima, entre otros.

La Supercomputación en 1990

Entre los ocho laboratorios estadoundienses, en realidad había sólo dos equipos dominantes, que ccontrolaban en la década de 1990 el mercado internacional:

- Thinking Machines Corporation, modelo CM-5/1024; y

- HPE Cray Supercomputing, modelo Y-MP C916/16256.

Thinking Machines Corporation (TMC) fue flor de un día.

TMC fue una compañía protagónica en esa década, pero sólo fugazmente. Se incubó en el Instituto Tecnológico de Massachusetts (MIT). Su fuerte fueron las supercomputadoras, con orientación hacia la inteligencia artificial.

Esa compañía, si bien pudo considerarse precursora de la supercomputación (provenía de la región Ivy League), en realidad resultó ser flor de un día.

Lo cierto es que el mercado de la supercomputación no estaba maduro para la demanda de equipos de supercomputación. El modelo original de Thinking se declararó en quiebra en 1994 y algunas de sus divisiones fueron a dar a Sun Microsystems.

Esa adelantada máquina SIMD, de Thinking, con 64 mil procesadores (CM-1), apenas pudo encontrar siete compradores en el mercado. Y lo hizo de modo localizado, entre laboratorios y grupos específicos de investigación.

Eso sí, sus siete compradores resultaron ser líderes de la supercomputación en los Estados Unidos en el Top 500 de 1993.

Nacimiento de Silicon Valley

Pensamos que el verdadero origen del garage, como espacio de innovación, debe atribuirse a Bill Hewlett y Dave Packard. No necesariamente a Steve Jobs, quien en 1976 repitió la experiencia al crear Apple en un garage, en Cupertino.

Desde la década de 1930, Bill Hewlett y Dave Packard hicieron de su pequeño garage en Palo Alto, su mayor laboratorio.

Y como ex compañeros de la Universidad de Stanford, pudieron aportar sus esfuerzos para transformar un valle destinado a la agricultura, en uno destinado a la tecnología: Silicon Valley.

El hecho es que, como Johnnie Walker, HP permanece dominante en 2025.

Domina en el ranking Top 500 de noviembre de 2025, y conserva el primer lugar en el desempeño de las mayores supercomputadoras en el mundo.

Equipa a cinco de los 10 laboratorios con mayor capacidad global. Entre ellos, al californiano del Departamento de Energia, conocido como El Capitán, al alcanzar -como señalamos antes- nada menos que 1,809.00 petaFlops.

Y por el momento, es suficiente.

¿Qué piensas de todo este ambiente de permanencia y reacomodos en la tecnología?

Fuentes:

Top 500. The List. Compilada por Erich Strohmaier (NERSC/Lawrence Berkeley National Laboratory), Jack Dongarra (University of Tennessee, Knoxville), Horst Simon (NERSC/Lawrence Berkeley National Laboratory) y Martin Meuer (Prometeus). Originalmente y hasta 2014, por Hans Meuer (University of Mannheim).

Departamento de Energía, Estados Unidos de América, “FY 2026 Congressional

Justification“, Cybersecurity, Energy Security, and Emergency Response, mayo, 2025.

HPE History, “The original pioneers of Silicon Valley“.

PICTET, “Los siete magníficos: descubre las empresas que parecen dominar el mundo de las inversiones”, octubre, 2024.

UBA, “Clementina XXI: una supercomputadora argentina entre las más poderosas del mundo”, s. f.

Tobin, Meaghan y Xinyun Wu, The New York Times International Weekly(Colaboración semanal en Reforma), “Ve trabas meta europea de chips”, 6 de diciembre, 2025.

Imagen de portada: Generada con Grok.