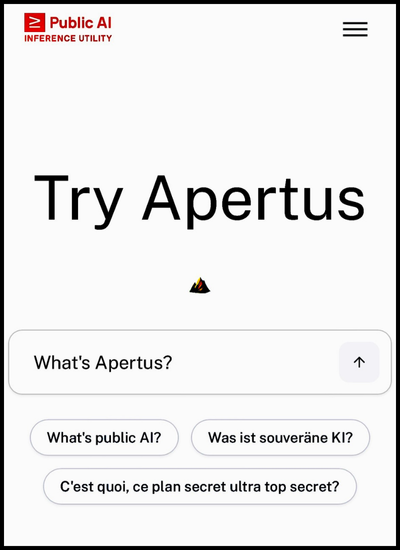

PolifonIA.org | Carlos Macías. El pasado mes de septiembre, la “Iniciativa Suiza de IA” presentó Apertus, el mayor modelo abierto de LLM hasta la fecha.

Apertus es desarrollado por un consorcio académico, financiado con fondos públicos.

La palabra Apertus se deriva del verbo en latín aperio (abrir). Es una conjugación de aperio, que se traduce como abierto.

El anuncio no es asunto menor. Muestra que se abre paso una alternativa abierta, pública y académica, entre los mayores Modelos Lingúisticos Grandes o extendidos (LLMs).

Toda proporción guardada, el modelo IA de Apertus rivaliza de hecho con ChatGPT, Gemini, Grok, Claude y DeepSeek.

Apertus puede preciarse de haber sido “creado con los valores suizos”: transparencia, capacidades multilingües y servicio público.

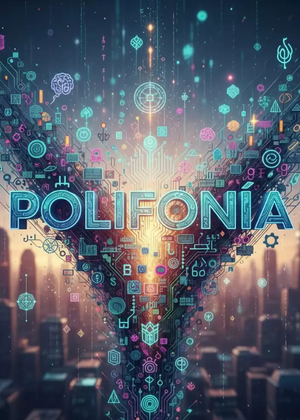

La organización llamada Public AI Inference Utility estima que Apertus muestra un “excelente rendimiento en diversas evaluaciones de conocimiento, culturales y de seguimiento de instrucciones”.

“Actualmente -refiere esta Iniciativa suiza-, es uno de los LLMs multilingües más potentes jamás lanzados por una institución pública”, y está disponible para todos a través de la Utilidad de Inferencia de IA Pública.

La llegada de Apertus refuerza la tendencia que inauguró GPT-J en 2021 (impulsado por EleutherAI). Es una tendencia que busca fomentar LLMs de código abierto, con el objetivo de democratizar la inteligencia artificial.

¿Cómo definir Apertus?

Apertus es una herramienta de inteligencia artificial. Su periodo de entrenamiento duró tres meses, para lo cual procesó 15 trillones de tokens de texto multilingüe. En el procesamiento del lenguaje natural, los tokens se definen como unidades básicas de texto. Son en realidad fragmentos de texto (palabras o incluso caracteres individuales).

Apertus es, por ello, un modelo de lenguaje multilingüe. Tiene capacidad para realizar tareas complejas, como generar texto, analizar contextos y sentimientos, traducir, razonar y comprender el lenguaje natural.

Posee técnicas avanzadas de aprendizaje automático y procesamiento de lenguaje natural. Su entrenamiento incluyó varios idiomas, entre ellos alemán, francés, italiano, romance y dialectos suizos.

La supercomputadora suiza, octava en escala mundial

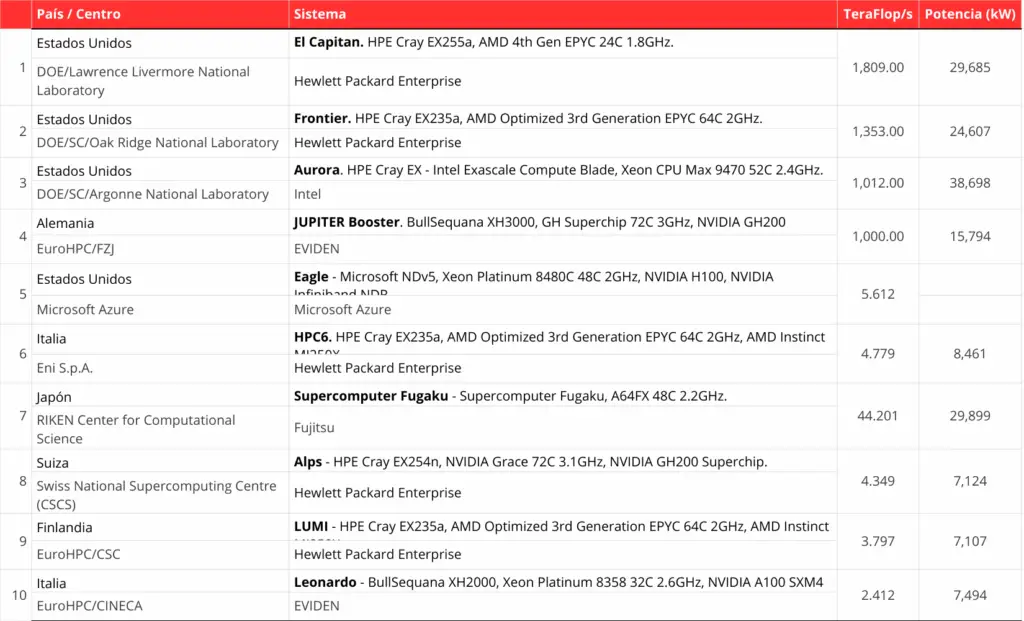

Apertus realizó su entrenamiento en la supercomputadora Alps (ver imagen abajo). Es una supercomputadora que tiene 4096 unidades de procesamiento gráfico (GPUs), de NVIDIA.

Alps es, de hecho, la supercomputadora pública de Suiza. Está albergada en el Centro Nacional de Supercomputación de Suiza (CSCS). Éste, a su vez, forma parte de un Centro de Investigación creado en 1855 como Politécnico suizo, denominado en nuestros días ETH Zurich.

Como se puede ver en nuestra nota anterior, Alps es la supercomputadora número ocho del mundo, trabaja con harware de HPE Cray y con procesadores Nvidia (superchip H200). Su capacidad de procesamiento en TeraFlops asciende a 4,349, con una potencia en kw de 7,124.

¿En qué consiste la Iniciativa Suiza de AI?

La Iniciativa Suiza de IA y Apertus son parte de un ambicioso esfuerzo tecnológico tripartita. Sus tres participantes se encuentran entre las instituciones europeas de mayor relevancia. Se trata de EPFL, ETH Zurich y del propio CSCS, con su supercomputadora Alps.

EPFL se precia como una de las instituciones de ciencia y tecnología más vibrantes y cosmopolitas de Europa; y ETH Zúrich (como señalamos, el Politécnico que nació en 1855), posee una reconocida proyección europea.

El tercer participante es el referido Centro Nacional de Supercomputación de Suiza (CSCS), que fue fundado en 1991, y que es operado por el propio ETH Zurich.

El CSCS es uno de los Centros de Supercomputación preferidos para la investigación de primer nivel, por su laboratorio disponible para académicos, tanto nacionales como internacionales, del mismo modo que para usuarios de la industria y de sectores empresariales.

La semilla de Apertus

Acerca de los modelos abiertos de lenguaje (LLMs), habría que colocar la iniciativa de Apertus como parte de la semilla que -en 2021- sembró el grupo EleutherAI, al crear GPT-J.

El objetivo de EleutherAI es y ha sido democratizar los modelos de lenguaje masivos.

Su modelo abierto GTP-J, con seis millones de parámetros, apareció en simultáneo con la versión de GTP3, de OpenAI, que contaba con 175 mil millones. En otro post abordaremos el interesante caso de EleutherAI.

Los GPT de OpenAI

Se impone presentar un breve recuento de lo ocurrido en estos últimos siete años en torno a la IA.

No ha pasado mucho tiempo desde que OpenAI lanzó el modelo lingüístico GTP1, en 2018. Pero parece una eternidad. GPT1 nació entonces con 117 millones de parámetros.

Como se sabe, OpenAI fue fundada en 2015 por Sam Altman (el mismo que aún la encabeza), Greg Brockman, Elon Musk (quien se retiró un par de años después), Jessica Livingston y Peter Thiel.

Vino más tarde GPT2 (en noviembre de 2019), con 125 mil millones de parámetros; y el GPT3 (en mayo de 2020), contó con 175 mil millones de parámetros.

GPT fue entrenado con más de 45 terabytes de datos que incluyeron materiales de la web, de common crawl, infinidad de libros y de wikipedia.

Desde entonces, empezaron a ser publicadas versiones intermedias de GPT. No se conoce con exactitud el avance posterior en los parámetros, pero se estima que las versiones posteriores ya incluyen billones de ellos.

ChatGPT (GPT 3.5) se catapulta

La serie GPT-3.5 se publicó el 30 de noviembre de 2022. Por vez primera, se impulsó bajo la modalidad conocida como ChatGPT, que causó una ola mundial en 2023.

Durante esa ola, en enero de 2023, publicamos una exposición con el resumen de novedades que traía ChatGPT. Después vinieron las versiones GPT4, GPT5 y GPT5.1. Ésta última apenas publicada en noviembre de 2025.

Por lo pronto, nos congratulamos con la llegada de un LLM fresco y abierto, como lo es Apertus, en el campo más popular de consuta de AI, mismo que hasta ahora es dominado por las grandes y conocidas organizaciones de innovación privada.

No olvides interactuar con Apertus, en este enlace.

¿Qué te parece la llegada del código abierto a los LLMs?

Imagen de la portada: Apertus: EPFL, ETH Zurich, y Swiss National Supercomputing Centre (CSCS).

Fuente: Bosselut, Antoine, Martin Jaggi e Imanol Schlag (Coords.), Proyect Apertus. Democratizing Open and Compliant LLMs for Global Language Environments. Apertus V1 Technical Report. 2025.