polifonia.org | Carlos Macías. Con frecuencia las personas integrantes del sector académico se preguntan cuáles serán los recursos de mayor utilidad que la IA estará en condiciones de proveer en el corto y mediano plazo.

Nos enfocaremos aquí en la revisión de aquellas herramientas que se preve puedan tener aplicación extendida en tareas que desarrollan los estudiosos de las Ciencias Sociales y las Humanidades.

Hasta ahora, la expectativa mayor suele centrarse en las herramientas de Inteligencia Artificial que puedan mejorar la metodología de investigación, en calidad y precisión. Tanto en el terreno cualitativo, como en el cuantitativo.

Después de todo, la IA propiciará un uso generalizado en innumerables espacios de la vida personal.

Para imaginar un paralelo cercano, quizá el mejor ejemplo a la vista sea el nacimiento, expansión y vitalidad que pudo alcanzar el internet, en un plazo relativamente corto.

Pero a diferencia de internet -que posibilitó la intercomunicación remota-, la Inteligencia Artificial tendrá una influencia transversal, merced a la propia red global de intercomunicación previamente tendida.

Una influencia que se traducirá en la renovación de las funciones, el trabajo y los procesos de todos los sectores de la actividad productiva y de servicios, de caracter privado y público.

Remontar el periodo de “alucinaciones” IA

A todos nos ha pasado. Solicitamos alguna información a un sistema de IA (o bien, le pedimos crear una imagen o un audio), y en cuestión de segundos recibimos la respuesta.

Nuestra primera reacción es reconocer que la ayuda inteligente es -a más de eficiente- veraz y coherente. Sea ChatGTP o cualquier otro LLM.

En seguida procedemos a analizar con detalle los párrafos de información (de la imagen o el audio) que incluye la respuesta.

No suele resultar extraño que identifiquemos imprecisiones o sesgos en el ágil servicio que nos proporcionó el LLM.

O bien, advertimos que ciertas fuentes de información han resultado poco consistentes con los hechos que conocíamos.

Porque se trata de información que, de alguna manera, hemos desmenuzado por otros medios.

Pues sí, en ese momento nos topamos con lo que se conoce como “alucinaciones” de la IA.

En descargo, debe aceptarse que los propios LLM han asumido las deficiencias presentadas en los últimos tres años.

Por ello producen de modo calendarizado nuevas versiones de sus sistemas generativos de IA.

Alucinantes deficiencias

Las deficiencias se han originado en la fase de entrenamiento de los modelos de datos, que resultaron precoces y defectuosos.

Es evidente que el origen de dichas “alucinaciones” proviene de inferencias érroneas, propias de un diseño algorítmico en proceso de depuración.

Las “alucinaciones” de la IA pueden causar muchos problemas, pero todas son remontables en el diseño.

En especial, en aquellas áreas que requieren de la precisión milimétrica y de la fiabilidad en cada respuesta o en cada modelo predictivo.

En áreas y actividades, por ejemplo, donde está de por medio la vida humana o decisiones que afectan directamente la integridad o los derechos las personas.

Tal es el caso de la salud, la seguridad, la gestión pública, la administración de la justicia, las finanzas y el clima, entre otras.

Menos alucinaciones, mayor adopción

Para tratar de acabar con las hallucinations que socaban la confianza en IA, los ecosistemas mayores han avanzado en la prescripción de protocolos y plantillas.

La idea es garantizar la fundamentación de las fuentes (grounding), y asegurar la cobertura de secciones obligadas en el entrenamiento de cualquier modelo de IA generativa.

Alphabet recomienda incluir en el entrenamiento, entre otros, los siguientes elementos.

- Título

- Introducción

- Cuerpo

- Conclusión.

Con todo, si asumimos la continuidad en el proceso de mejora del entrenamiento de modelos IA, es probable que las cosas se desenvuelvan de la siguiente manera, como parte del crecimiento de la Inteligencia Artificial en 2026.

A finales de este año, casi todos los programas que utilizaremos en nuestros dispositivos contarán con al menos alguna función adicional basada en la Inteligencia Artificial.

Aún más. A finales de 2026, las tareas para diseñar aplicaciones basadas en códigos ya estarán bajo la esfera de IA (no de las personas especialistas). Con la supervisión humana.

De modo que nos encontramos en la fase de creación intensiva de agentes.

Agentes para todos

Diríase que un agente es -valga la simplificación- una especie de paquete de instrucciones complejas y específicas que se dirigen a los sistemas de IA.

Están siendo diseñados para actuar de modo automatizado, con autonomía, a nombre de nosotros. Su diseño incluye las capacidades de razonamiento, planificación y memoria.

En nuestros días, apreciamos que la multiplicación de agentes continúa desatada. Al parecer, Claude (de Anthropic) lleva la delantera.

Cada vez abundan más agentes que se encargan con agilidad de desarrollar tareas de codificación para crear nuevas aplicaciones.

El siguiente esquema nos ayuda a distinguir con claridad la diferencia entre agente, asistente y bot.

Tipo de aplicaciones IA que colaboran en tareas para los usuarios

| Agente de IA | Asistente de IA | Bot | |

|---|---|---|---|

| Objetivo | Realizar tareas de forma autónomay proactiva | Ayuda a los usuarios con las tareas | Automatización de tareas o conversaciones simples |

| Funciones | Puede realizar acciones complejasde varios pasos; aprende y se adapta, y puede tomar decisiones de forma independiente | Responde a solicitudes o instrucciones, proporciona información y completa tareas simples; puede recomendar acciones, pero el usuario toma las decisiones | Sigue reglas predefinidas; aprendizaje limitado; interacciones básicas |

| Interacción | Proactivoy orientado a los objetivos | Reactiva; responde a las solicitudes de los usuarios | Reactivo; responde a activadores o comandos |

Los agentes también harán su fiesta, antes de entrar en razón

Sin novedad. Es previsible que la escena siguiente de la película “inquietud social ante la IA” sea protagonizada por los agentes.

A partir de la creación de Codex AI (mayo 2025), el mayor agente de OpenAI, ha crecido aún más ese género de aplicaciones en diversos ámbitos.

A finales de enero de 2026, la mayoría de los temores provenían del espacio empresarial, por la incursión desaforada de agentes IA, “sin controles de seguridad”.

La compañía Cybersecurity Insiders se refiere a ello como la explotación de puntos ciegos.

Las empresas descubren de repente “herramientas de IA no autorizadas ya operando dentro de sus entornos. Frecuentemente incorporadas con credenciales o acceso elevado al sistema que nadie está monitoreando”.

A decir verdad, hace mucho tiempo que las aplicaciones de innumerables redes sociales y de proveeduría de servicios en línea, conviven con información nuestra en plataformas, cuentas y perfiles.

Por tanto, algún trabajo fuerte en consenso supranacional habrá de realizarse. Se deberá establecer con claridad la línea infranqueable de privacidad en los datos personales y corporativos. Ello ayudará a realinear de modo normado los propósitos mayores del ecosistema IA.

Ahora sí: de ruptura en ruptura

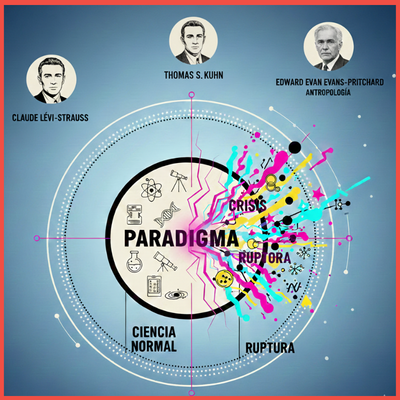

El avance y la transformación del conocimiento humano es un proceso que no se detiene.

La aparición recurrente de saltos en el saber científico, bajo la caracterización de ruptura epistemológica (en términos de mediados del siglo XX), da cuenta del dinamismo natural que experimentan las ciencias y sus recursos de trabajo.

[Sobre la tensión natural que Thomas S. Kuhn identifica entre el periodo pre-paradigma y el post-paradigma, véase su Posdata de 1969 en la Estructura de las Revoluciones Científicas (orig. 1962)].

Apenas hace 170 años, la ciencia acertó a deslindar con cierta claridad los campos y las herramientas que corresponden al conocimiento de la naturaleza, de aquellos que corresponden sólo al de la sociedad.

Por entonces, Augusto Comte propuso aplicar algunos criterios ya empleados para entender la física y la biología.

Se trataba de comprender mejor a la sociedad (física social), y con ello este pensador galo firmaba el acta de nacimiento de la ciencia social.

A partir de ahí, un problema mayor llegó para los estudiosos de los procesos sociales.

Identificar leyes generales de la sociedad (vaya reto) en la etapa ya adjetivada como positiva o científica.

Hacerlo con base en procedimientos nacidos en otros campos del conocimiento, motivados por los mecanismos de observación y la medición.

[Véase la primera lección de su Curso de Filosofía positiva (1875, pp. 69-120), disponible en pdf].

Bienvenido el amanecer de la metodología cualitativa, con aplicación a los estudios sociales.

De leyes generales a hechos sociales

Llegó otro francés, Émile Durkheim, a matizar la visión de las leyes generales.

¿Dónde quedaba la diferencia entre lo individual y lo social, dentro del “atomo” (familia) que Comte había identificado como unidad basica del “organismo social”?

¿Dónde quedaba la distinción entre lo subjetivo y lo objetivo?

Si por entonces ya se podían identificar ciertas causas de origen social en las conductas de las personas, era recomendable referirlas mejor -apuntó Durkheim- como hechos sociales.

Y más exactamente, hechos sociales medibles.

Así lo desarrolló en su obra clásica El suicidio, a finales del siglo XIX, uno de los ejercicios más rigurosos de análisis estadístico en el campo social hasta entonces.

[Véanse, en especial, los libros segundo y tercero (1897), disponibles en pdf].

Bienvenido el amanecer de la metodología cuantitativa, enfocada a los estudios sociales.

Cambiar de paradigma

En todo caso, debemos reconocer el gran paso adelante que representó la obra del alemán Max Weber, al distanciarse del acento en las leyes generales en la sociedad.

Weber introdujo una idea que ayudó a reconocer y a comprender la conducta humana (no sólo a medirla).

Tuvo y tiene como escenario a la acción social, a la historia y a la cultura.

[Si se desea abundar, véase el extracto de la obra póstuma Economia y Sociedad (1921-1922). Ahí Weber desarrolló diversas formas de dominación tradicional, fincadas en una “acción social brotada de ‘sentimientos’ irracionales”].

Emplea la noción de verstehen (comprensión interpretativa, 1905), para contrastarlo con la hegemonía de las normas sociales que había planteado Durkheim (1897).

El proceso de interpretación, a partir de ahí, ha resultado clave hasta nuestros días.

Caracterización histórica de la etnografía

Conviene preguntar en qué momento la etnografía afinó su condición centenaria, como procedimiento de observación y de registro de acciones humanas in situ.

Es decir, cuándo incursionó como una herramienta científica privilegiada.

De sobra se sabe que la etnografía, como actividad, siempre ha representado un componente imprescindible del proceso de investigación social.

Aborda el complejo conjunto de subjetividades que habitan el mundo social. Por ello, en términos reales cuenta con una herencia añosa.

Se basa en una tradición que se remonta al menos hasta los siglos XVI-XIX, y que sustenta de modo central la estructura argumentativa de incontables libros y memorias de viaje.

Sean Hernando Colón, Fray Bernandino de Sahagún y, en especial, el prolífico Gonzalo Fernández de Oviedo, u otros autores posteriores.

Ahí estaba la costumbre de ejercer una fiel observación y registro escrito sobre acciones y conductas humanas que podían presenciarse.

(Fray Diego de Landa empleó integralmente el lenguaje como vehículo para internarse en el terreno social, cultural y religioso, en la década de 1540).

Lo hicieron con fines deliberados de escritura, explicación y propagación.

Por ello, bien podrían ser considerados como proto etnógrafos.

Etnografía que llegó para quedarse

Es de destacarse la gran relevancia y ruptura que detona el trabajo de campo.

Justo cuando empieza a emprenderse como parte integrante del proceso de investigación.

Es decir, un trabajo profesional prolongado, con cuadernos de notas. Con espacios de tiempo programados y nuevos recursos tecnológicos para su aprovechamiento. Conceptualizado como tal, como recurso indispensable.

El punto cronológico de arranque, en todo caso, no puede ser otro que a finales del siglo XIX.

A partir de entonces se confiere a la etnografía un carácter científico, como parte integral y sistemática de la nueva investigación en el medio social.

Vino la inmersión, el reto por comprender la vida social y cultural, así como las conductas individuales.

Habrían de desfilar, en ese orden, los trabajos de Franz Boas (The Central Eskimo, 1888). De Robert Park (en el contexto urbano de Chicago: La Ciudad, 1925). De Bronislaw Malinowski y de Margaret Mead.

Posteriores dilemas nacieron en torno a las implicaciones del exotismo, la etnometodología y la reflexividad. Y seguirán.

Ahora, henos aquí.

De dónde son los cantantes

Cuando se habla de software para uso académico, hasta ahora la constante ha sido que grupos de investigadores emprendan la concepción, el diseño y el desarrollo de la paquetería.

Suele ocurrir que, con el tiempo, alguna compañía adquiera los derechos y confiera una visión mayor, más ambiciosa, al desarrollo y la puesta en el mercado del software en cuestión.

El botón de muestra lo vimos aquí en al menos dos artículos anteriores. Así pasó con el Índice Top500 de la Supercomputación y con el leguaje COBOL (1959).

También con la reciente suite australiana Q-CTRL para la navegación cuántica, entre varios ejemplos.

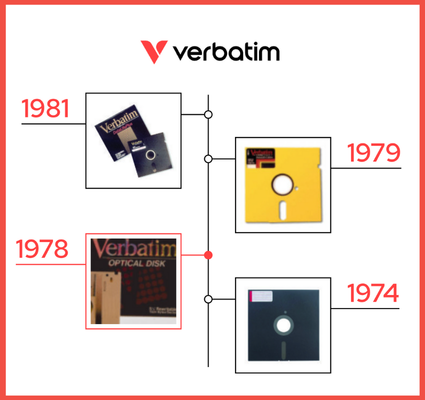

Ahora lo vemos con el SPSS, concebido por profesores de la Universidad de Chicago en 1968, los mismos que hicieron posible su lanzamiento para el sistema operativo de PC en 1984.

Recursos para la metodología cuantitativa

Las necesidades inscritas en el enfoque social de la medición propiciaron el crecimiento de paqueterías encaminadas a respaldar la metodología cuantitativa.

Quizá el programa de mayor consolidación, por su antigüedad, sea el Statistical Package for the Social Sciences, conocido como por sus siglas SPSS.

Se incubó a finales de la década de 1960 en la Universidad de Chicago, pero inició su popularidad ya bien entrada la década siguiente.

La omnipresencia de SPSS

Este programa de Chicago con el tiempo ganó popularidad, en la academia y en los sectores público y privado.

Llegó a ser una herramienta central, para realizar análisis estadísticos, minería de datos, proyecciones y modelos de predicción.

El SPSS terminó en manos de la IBM en 2009. Hablamos justo del periodo en que ocurrió la reconversión de IBM que comentamos en la sección “Los tres dominantes” del artículo anterior (2004-2014).

Por entonces, la IBM vendió sus divisiones de computadoras personales (PC) y de servidores x86 al grupo chino Lenovo.

La IBM prefirió quedarse sólo con las divisiones de servidores y almacenamiento. (Es lider actual en la arquitectura interior de computación de alto rendimiento: supercomputadoras). También se concentró en la proveeduría de servicios y de sotware. En ese contexto adquirió el programa SPSS.

En nuestros días, el IBM SPSS es el paquete de software estadístico dominante. En especial, para las ciencias sociales y la investigación académica (para encuestas, de modo señalado).

El código abierto gana terreno

Le sigue, en orden de empleabilidad, RStudio, que fue adquirido en 2024 por la empresa que promueve el código abierto Posit.

RStudio funciona con código abierto y es gratuito, siempre y cuando sea empleado para propósitos personales y profesionales.

Existen versiones con aplicación empresarial, que tienen costo según el plan a elegir.

Posit puede realizar análisis estadístico y previsualización de datos, pero es importante señalar que requiere ciertos conocimientos para su configuración.

De hecho, RStudio es soportado por el lenguaje R de computación. Ello ha facilitado su transición al modelo conocido como Entorno de Desarrollo Integrado (IDE).

La particularidad del IDE es que permite interactuar con Python y así facilitar su compatibilidad y acceso a IA.

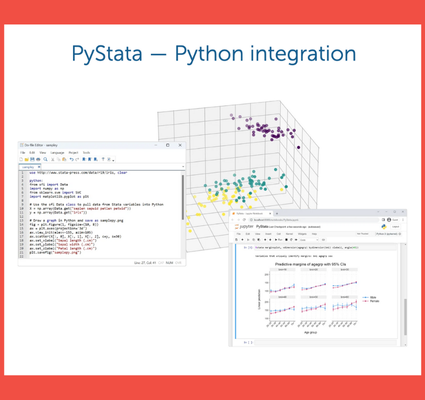

También se impone aludir a Stata; su preferencia se dirige a sectores de dedicados a la economía, las finanzas y la salud pública (particularmente la epidemiología y la demografía).

RStudio y Stata, en pos de la IA

Los tres paquetes referidos antes, como herramientas enfocadas a la metodología cuantitativa, buscan incorporar en su oferta las ventajas potenciales que tendrá su vínculo con la Inteligencia Artificial.

Desde finales de 2025, la IBM ofrece agentes de IA para maximizar el empleo de los datos que se obtienen en SPSS, y así extraer mejores resultados analíticos.

Stata, por su parte, posee cierta ventaja que lo hace más flexible para economistas y epidemiólogos.

Puede transferir datos a Python, lo que en teoría contribuye al mejor procesamiento de datos y a su afinidad, decíamos atrás, con los sistemas de Inteligencia Artificial.

Quizá el mayor atributo de SPSS sea su versatilidad, al crear gráficos accesibles para ser editados y, en su caso, ser publicados.

En cambio, Stata suele dar más trabajo y se deben configurar comandos, para lograr buenos gráficos.

Stata asegura que su sintaxis “es intuitiva y fácil de aprender y enseñar”.

Pero el hecho es que es necesario dominar la sintaxis del comando de gráficos.

Una vez logrado ello, se podrá navegar sin dificultad en el interfaz de Stata, para aprovechar su potencial estadístico.

Tanto el acceso a SPSS como a Stata se realiza mediante la adquisición de licencias institucionales (con un costo considerable).

Aún así, debe decirse que Stata cuenta con opciones un poco más accesibles, para personas que cursan el ciclo universitario.

Como señalamos arriba, PStudio de Posit se cuece aparte, porque se puede descargar e instalar de modo gratuito, si es para trabajo personal y profesional.

El nicho de los justos: código abierto y gratuito

Colocaremos a PStudio o Posit, al lado de WordPress y de Moodle.

WordPress es el mayor Sistema de Gestión de Contenidos (CMS) para internet.

Moodle es el Sistema de Gestión de Aprendizaje (LMS) preferido por las instituciones educativas.

Las tres son plataformas poderosas, confiables y populares, que proporcionan el código abierto, lo que permite su descarga gratuita y la configuración ad hoc.

(Por ejemplo, gracias a WordPress hemos levantado sin costos el presente sitio de polifonia.org).

Recursos para la etnografía y la investigación cualitativa

Incursionar en la revisión de las plataformas que podrían contribuir en el proceso de investigación cualitativa, nos conduce sin rodeos a los terrenos mundanos de la etnografía digital.

Existe una constelación de compañías dedicadas a la investigación cualitativa, pero casi todas están enfocadas a la investigación de mercado.

Son especialistas en antropomarketing, en etnografía del consumidor, en sociología industrial o en antropología del consumo.

Cuentan entre sus principales estrategias de trabajo con la observación participante en la vida diaria, a despecho de Bronisław Malinowski.

Las compañías dedicadas al análisis cualitativo mantienen plantillas que suelen realizar trabajos inscritos en las especialidades de antropología y sociología. Pero -según datos de una encuesta aplicada en 2023– tan sólo el 11% de sus integrantes proviene de origen de ambas disciplinas.

Las plataformas con capacidades para la investigación cualitativa ocupan diversos segmentos.

Aquí nos vamos a concentrar en las que han emplazado sus expectativas hacia la IA, porque reflejan mayor sensibilidad a la actualización.

Conviene apuntar, no obstante, que todo protagonismo en IA parece estar reservado -no por casualidad- para aquellas compañías globales de tecnología.

Son las únicas que están preparadas para ello: infraestructura, redes, investigación.

[Véase el significado de lo que llamamos familia sinérgica Google, en los TPU de Alphabet].

Los QDAs de interés

En términos generales, los recursos disponibles en este campo han sido definidos como QDA (Qualitative Data Analysis).

Existen numerosas plataformas, pero puede sostenerse que son cuatro o cinco dominantes, que incluyen herramientas de utilidad académica: Atlas.ti, Nvivo, Indeemo y ethOS.

La dos primeras (Atlas.ti, Nvivo) se caracterizan como herramientas para el análisis profundo (CAQDAS).

Las dos últimas (Indeemo y ethOS) son conocidas como aplicaciones capaces de recolectar datos en tiempo real, y por ello son útiles para el trabajo etnográfico.

También revisaremos otras plataformas emergentes de IA, que bien pueden auxiliar las labores en el campo de la etnografía digital y la netnografía.

En especial, las plataformas emergentes en línea IA, como NotebookLM y Mi Espacio de Perplexity Académico.

Ambos sitemas de IA ofrecen ventajas para la etnografía digital: registro y convergencia de notas, videos, imágenes y audios.

El concepto de netnografía, por cierto, todo parece indicar que fue acuñado por el investigador de comunidades en línea, Robert V. Kozinets, de la Kellogg Graduate School of Management. Con ello, anticipó las implicaciones que adquiriría la conducta del consumidor en la red.

Incorporó desde la década de 1990 el desestimado vínculo de los hábitos de consumo con la naciente cibercultura.

[Véase su estudio temprano sobre el empleo de la netnografía].

Atlas.ti y NVivo

Ambas pueden considerarse plataformas de investigación con una misión común.

La primera fue fundada entre 1989 y 1992 por el profesor aleman Thomas Muhr, de la Universidad Técnica de Berlín, bajo la denominación de Scientific Software Development.

Esta pequeña compañía se especializó en el análisis de datos cualitativos. En ese estatus pudo resistir, como independiente, hasta el año de 2024, en que fue adquirida por el grupo estadounidense Lumivero.

Y aquí la primera observación, relativa al proceso de concentración de mercado.

Dos de las más reconocidas plataformas que organizan y analizan grandes fuentes de datos (Atlas.ti y NVivo), ahora pertenecen al grupo Lumivero.

Ambas, sin dificultad, están incorporando sus funciones a los sistemas IA.

Atlas.ti es empleada por numerosas universidades e institutos, para el manejo masivo de información en su plataforma.

Cuenta con aplicaciones para realizar entrevistas, encuestas, grupos focales, revisión de la literatura, notas de campo y otras herramientas cualitativas, basadas en observaciones (procesos o acciones).

NVivo, en cambio, se originó en 1994 en una universidad australiana (La Trobe), con el nombre de Qualitative Solutions and Research Pty Ltd.

Atlas.ti se enfoca en una experiencia con interfaces amigables y Nvivo se enfoca en una gestión colaborativa.

Etnografía digital en Indeemo

Indeemo es una compañía fundada en 2016 por el profesor Eugenio Murphy, en Cork, Irlanda.

Quizá es la única compañía dedicada a proveer herramientas de etnografía digital, que no ha sido absorbida por las grupos empresariales dominantes. Podemos decir que aún se mantiene independiente.

Obliga destacar aquí el valioso apoyo que le otorga a Indeemo la agencia gubernamental encargada de promover la innovación y el crecimiento de las empresas: Enterprise Ireland.

[Véase el video de Murphy, acerca su experiencia en etnografía móvil].

La especialidad de Indeemo es la etnografía digital, con el uso de aplicaciones en tiempo real. Presume haber llevado a las empresas el recurso de la etnografía móvil.

Ha apostado por esta vía. Considera a la etnografía móvil:

- “una metodología valiosa… Aprovecha el mayor poder de los teléfonos inteligentes y nuestra mayor conectividad.

- La etnografía móvil ayuda a los investigadores a descubrir información auténtica y contextualizada sobre el comportamiento de los encuestados.”

Los lectores pueden descargar un documento en pdf de Indeemo (“An Introduction to Mobile Ethnography”), en forma gratuita, mediante registro previo.

La plataforma móvil de Indeemo se inscribe en la modalidad de investigación cualitativa en tiempo real.

Indeemo destaca la alta utilidad de la plataforma para el trabajo de campo, la evaluación ecológica momentánea (EMA), la investigación fotovoz y la investigación-acción participativa.

Y expresa su disposición a escuhar solicitudes de financiamiento para proyectos.

Ethos neoyorquina

La competencia directa en el mercado de Indeemo, es una compañía estadounidense, con sede en Nueva York.

Ethos es una plataforma de investigación que, igual, ofrece un amplio conjunto de herramientas.

El nombre de la compañía EthOS es Sistema de Observación Etnográfica. Ello “refleja -señalan- nuestra profunda historia en la etnografía y el estudio de las personas”.

Ethos fue fundada por el antropólogo y etnógrafo Siamack Salari, originario de la India.

Sus estudios los realizó en Francia e Inglaterra, pero coronó su formación, como investigador visitante en temas organizaciones, en la King’s College London’s Department of Management (2012).

Curiosamente, antes de fundar Ethos (2011), en un esbozo de su trabajo sobre Etnografía de las artes(2008), se le definía así:

“Siamack Salari is a champion of commercial and video ethnography around the world”.

Ethos recogió esa experiencia. Su plataforma está habilitada para realizar estudios de diario, encuestas en video, etnografía móvil, pruebas de concepto y análisis de entrevistas.

Una más: Ethos fue adquirida en agosto de 2024 por otro grupo neoyorquino, fundado en 2016. Su especialidad: investigación de mercados.

Su nombre: OvationMR (Ovation-Worldwide Holdings, LLC).

¿Qué más podría reseñarse? En la obtención de las licencias de la plataforma Ethos, se ofrecen descuentos para estudiantes y profesores de universidades y organizaciones no lucrativas.

Los nietos de Schlesinger

En el espectro de plataformas de investigación cualitativa, existe una especie de holding británico que ofrece gran cantidad de servicios.

Llama la atención porque ha realizado un conjunto de adquisiciones relativamente recientes.

En el 2025 adoptó el nombre de Sago. Se trata de la empresa de la familia británica Schlesinger (Schlesinger Group).

Sago se precia de ser una firma global, líder en investigación y recolección de datos. Es dirigida por Steve Schlesinger.

Tan sólo entre 2019 a 2022, Sago adquirió siete compañías relacionadas con su ramo.

Entre ellas, 20|20 Research, una organización fundada en 1996, con una plataforma de etnografía digital propia.

20|20 Research y Over the Shoulder

Sago no sólo cambió el nombre de 20|20 Research, también encomendó al nuevo equipo la responsabilidad de crear una División de Investigación Cualitativa Digital.

Y remolcó con ello a otro equipo de tamaño menor, pero significativo (Over the Shoulder).

Desde el 2013, el equipo de Over the Shoulder había permanecido mejorando las prestaciones de su aplicación móvil (QualBoard), con una tecnología propia, enfocada en etnografía en tiempo real y notas diarias móviles.

Over the Shoulder era catalogada apenas detrás de Ethos, por la calidad y ventajas de su plataforma en el trabajo en campo.

Pero si bien el tamaño del equipo de Over the Shoulder era reducido, su aportación en Sago no ha sido menor.

Over the Shoulder encabezó la transición desde lo que ellos llaman etnografía tradicional (presencial) hacia la etnografía digital, en especial en el sector del que son fuertes: experiencia de usuario (UX).

De Google Forms a QuestionPro

En el frente de batalla cotidiano, para crear formularios y encuestas que recopilan datos, con la inclusión de estadísticas, ya sabemos que contamos con Google Forms.

También suele emplearse para ello QuestionPro, que tiene un potencial mayor. Ofrece la posibilidad de crear una cuenta gratuita.

Puede auxiliarnos en diferentes procesos metodológicos, para crear y aplicar encuestas, obtener una segmentación geográfica y efectuar análisis cualitativo.

Con la cuenta grauita de QuestionPro puedes exportar los datos recabados a Google Sheets y aplicar encuestas sobre un máximo de 20 temas.

La interfaz permite colocar tu logotipo en los cuestionarios en línea.

Está concebido para conducir a los clientes al siguiente paso (el anzuelo IA), para contratar un plan. Resiste, piénsalo dos veces.

Si eludes el anzuelo de contratación, tendrás mayor oportunidad de explorar otras opciones.

QuestionPro fue fundado por un equipo encabezado por Vivek Bhaskaran hace más de 15 años, en Austin, Texas. Bhaskaran nació en la India, pero realizó sus estudios desde muy joven en Estados Unidos.

Egresó de la Universidad Brigham Young (Utah). En fecha reciente, ha llegado a ser columnista y consejero de Forbes.

QuestionPro es una de las compañía más sólidas en cuanto a herramientas de investigación de mercados, pero debe decirse que en sus productos aún no se perciben (a enero de 2026) planes que aseguren la eventual incorporación de aplicaciones IA en su plataforma. Es probable que pronto lo hagan.

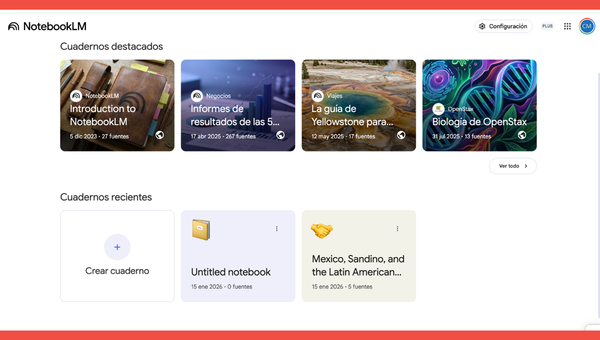

NotebookLM: notas, resumenes y presentaciones compartidas

¿Cuántos años te has apoyado con alguna versión de Notes (Apple) o de OneNote (Microsoft)?

Si lo has hecho al menos alguna vez, es probable que estés familiarizado con la organización de blocs y apuntes.

Quizá te hayas beneficiado de la convergencia de tus notas con la agenda digital, y de la fácil transferencia de información.

Hasta ahora, ambas aplicaciones continúan en función, pero parecen haberse quedado atrás.

Incluso, OneNote dejó de estar disponible para editarse dentro de Windows 10, aunque sigue vigente desde Microsoft 365.

En cambio, la nueva NotebookLM de Google (Alphabet) funciona justo como un cuaderno inteligente. Representa un paso adelante.

Está conectada a los TPU de Google y, por tanto, es convergente con IA.

Resulta apta para analizar fuentes documentales, textos, audios y, con ello, auxiliarnos en el proceso de la investigación.

Nació en 2023, incubada en Google (Alphabet) como “Project Tailwind”.

Sin embargo, fue hasta el año pasado (en mayo) cuando empezó a estar disponible en dispositivos celulares. Incluye una versión web.

Los cuadernos de NotebookLM

NotebookLM ha crecido como una de las aplicaciones más populares.

Lo es, al menos, por auxiliarnos en la tarea multimodal de nuestro tiempo, que se encierra bajo la frase paladina de facilitar la creación de contenido.

En la imagen que incluimos se aprecia un cuaderno posible.

Creamos el cuaderno con un conjunto de fuentes que podrían ayudar a conocer e interpretar un tema elegido al azar.

Por ejemplo, el motivo de la larga estancia de Augusto César Sandino en Yucatán, a finales de la década de 1920.

NotebookLM revisó las cinco fuentes que subimos (secciones hemerográficas y capítulos de libros) y nos presentó un resumen escrito y uno en audio en inglés, con voz sintética.

En suma, el género del que forma parte NotebookLM puede definirse como “asistente de IA basado en fuentes”.

Uno puede crear distintos cuadernos (en la versión gratuita), para agrupar múltiples fuentes. Desde luego, en esta versión los cuadernos son limitados.

Con ellos se pueden crear resúmenes, presentaciones visuales, cuestionarios y, lo más llamativo, síntesis producidas en audio, con voces de IA.

A propósito, debemos señalar que un programa adicional recomendable, que podría ser buen complemento de NotebookLM, en la producción de videos, es Wondercraft.

Podría pensarse que Wondercraft es uno de tantos estudios de video. Y es cierto.

Pero tiene la ventaja de incorporar modelos recientes de IA, para estar en condiciones de aprender y clonar nuestras voces. Así mejora sensiblemente la producción de podcasts.

PerplexityAI

Existen plataformas similares a NotebookLM.

Cada vez más herramientas proponen ayudarnos a organizar materiales de investigación. Quisiéramos aquí destacar a PerpexityAI.

Entre los LLM, es probable que PerpexityAI no sea el más conocido, ni el más celebrado.

Nació como motor de búsqueda en 2022, respaldado financieramente por Amazon. El propósito expreso parecía novedadoso en su momento. A la fecha, ha actualizado su navegador IA con el nombre de Comet.

Mantiene de modo loable una versión con análisis y resumen de cada resultado en su motor de búsqueda. No sólo se limita a enlistar las referencias localizadas.

El navegador representó una ventaja para PerplexityIA en 2022, con gran fidelidad con las fuentes enlistadas en sus resultados de cada búsqueda.

Pero ha sido en nuestros días replicado, ya sin dificultad por varios LLM.

Entre otros, por Gemini. Pero sobre todo por el propietario del mayor ecosistema IA, que cuenta con el motor de búsqueda dominante: Google.

No importa. Lo que interesa destacar de Perplexity es su plataforma Spaces. Reúne capacidades muy similares a las que ofrece NotebookLM.

Mis espacios de Perpexity es, en realidad, un menú posible de cuadernos por tema.

Uno los puede agrupar, como colección de fuentes. La plataforma no sólo los agrupa, los analiza y nos ofrece una conciliación y una síntesis ágil.

Se percibe que predominan en esta plataforma el tipo de lectores que tienen interés en la política, las finanzas y las predicciones.

Perplexity Académico puede resultar un espacio atractivo de trabajo, para quienes realizan tareas inscritas en las ciencias sociales y las humanidades.

Conclusión

Consideramos que continuará el proceso de mejora en el entrenamiento de modelos IA, con medidas expresas compartidas, como las planteadas por Alphabet (para minimizar las “alucinaciones” de la IA que explicamos al inicio).

Como parte del crecimiento de la Inteligencia Artificial en 2026, estimamos que casi todos los programas que utilizamos en nuestros dispositivos contarán con al menos alguna función adicional basada en la Inteligencia Artificial.

A finales de 2026, las tareas para diseñar aplicaciones basadas en códigos ya estarán bajo la esfera de IA (no de las personas desarrolladoras). Con la debida curación de contenidos y edición humana.

Ante la multiplicación de la oferta de aplicaciones IA, nos interesa insistir en la importancia de evitar contratar planes de cualquier tipo en plataformas existentes, sin antes realizar una amplia revisión de cada una.

Se deben comparar minuciosamente las desventajas (o ventajas concretas) de los planes de pago.

En primera instancia, recomendamos los planes gratuitos (evita caer pronto en un anzuelo IA). Son los adecuados para el uso diario, a pesar de que pueden resultar muy limitados. Ya los evaluarás.

Las múltiples suscripciones y los pagos mensuales -flujo de dinero hormiga- habrán de ser, probablemente, uno de los mayores dolores de cabeza del consumidor IA, en el porvenir.

¿Qué piensas de esta oleda de información IA?

Imagen de la portada: el trabajo etnográfico, según Gemini 3.

Fuentes:

Boas, Franz, “The Central Eskimo”, Sixth Annual Report of the Bureau of Ethnology to the Secretary of the Smithsonian Institution, 1884-1885, Government Printing Office, Washington, 1888, pp. 399-670 (The Project GutenbergeBook).

Burnam, Lizzy, “15 digital ethnography tools for remote ux research”, en User interviews by user testing, 17 de noviembre, 2013.

Comte, Augusto, Principios de filosofía positiva, prefacio de E. Littré, Santiago de Chile, Imprenta de la Librería del Mercurio, 1875. (Biblioteca Virtual Miguel de Cervantes).

Choi, Anna y Katelyn Xiaoying Mei, “What are AI hallucinations? Why AIs sometimes make things up“, en The Conversation, marzo 21, 2025.

Duffy, Francis, “Sociología interpretativa de Weber“, Ebsco host, 2021.

Durkheim, Émile, El suicidio. Un estudio de sociología, Epublibre, s.f.

Fernández de Oviedo, Gonzalo, Historia general y natural de las Indias, islas y tierra-firme del mar océano. Tomo segundo de la segunda parte, tercero de la obra, Alicante, España, Biblioteca Virtual Miguel de Cervantes, 2011.

Google Cloude, “¿Qué son las alucinaciones de la IA?“, Fundamentar tu IA, s.f.

Kozinets, Robert V., The Field Behind the Screen: Using Netnography For Marketing, Kellogg Graduate School of Management Evanston, IL. (marzo, 2001).

Kuhn, Thomas S., Estructura de las Revoluciones Científicas, México, FCE, 1962.

MRS, “20/20 Research buys Over the Shoulder”, en Research Live, 10 de diciembre, 2019.

Park, Robert Ezra, La Ciudad y otros ensayos de ecología urbana [1925], Ediciones del Serbal, Barcelona, 1999.

Weber, Max, Economía y Sociedad. Esbozo de sociología comprensiva, FCE, 2002.