PolifonIA.org | Carlos Macías. El pasado jueves 11 de diciembre, el presidente Donald Trump emitió una orden ejecutiva dedicada a la inteligencia artificial. Con esta disposición parece quedar despejado el sendero normativo de la IA para 2026: Europa, China y EU.

¿Así ocurrirá? ¿Existen condiciones en el mundo para contar con marcos regulatorios sostenibles para la Inteligencia Artificial?

A estas preguntas intentaremos responder a lo largo de este artículo, con base en las propias dinámicas nacionales, regionales, sectoriales, tecnológicas y de crecimiento exponencial de usuarios.

Una orden ejecutiva que centraliza sin rubor la regulación IA

La orden ejecutiva del presidente Trump se titula “Garantizar un marco político nacional para la inteligencia artificial”.

Cuenta con nueve secciones, mismas que toman como punto de partida el deslinde con la política sectorial que impulsó su predecesor, el presidente Joe Biden.

No queda duda de la beligerancia trumpiana, desde el primer párrafo:

- “Revoqué el intento de mi predecesor por paralizar esta industria, y ordené a mi Administración que eliminara las barreras al liderazgo estadounidense en IA”.

Creemos que la orden ejecutiva del presidente Trump luce como un monumento a la centralización de las decisiones en el plano federal, para incidir en el fomento y en el desarrollo de la Inteligencia Artificial en los Estados Unidos.

La ruptura con el pasado inmediato

El documento precisa no sólo los términos de aquella orden fundadora que emitió el presidente Trump en su primera administración, en febrero de 2019 (la núm.13859).

También reencauza la perspectiva que inspiró al presidente Biden para conducir un “Desarrollo y uso seguro, protegido y confiable de la inteligencia artificial” (orden ejecutiva núm. 14110, de octubre 2023).

De hecho, la orden ejecutiva del presidente Biden había sido revocada desde enero de 2025.

En su lugar, el recién llegado presidente Trump emitió con diligencia la orden provisional que llamó, de modo sugestivo: “Eliminando barreras al liderazgo estadounidense en inteligencia artificial”.

La nueva perspectiva culmina, por tanto, con la orden ejecutiva dada a conocereste 11 de diciembre, con una visión notablemente centralizada.

Si bien es una visión afín al modelo constitucional presidencialista de los Estados Unidos, creemos que elude el juego de participación federalista (presencia de los estados).

Dicha visión centralista sería, por lo demás, por completo afin al modelo presidencial vigente en México desde el siglo XIX.

¿Cuál es la nueva visión estadounidense sobre IA?

Como señalamos, el documento presenta nueve secciones. Todas ellas reiteran algo similar: buscarán que las 50 leyes estatales sobre IA queden subordinadas a la visión que mantengan las disposiciones federales en ciernes.

El contenido de la orden ejecutiva refleja la intención de contrarrestar las regulaciones estatales que últimamente han proliferado.

Después de la lectura, nos queda la impresión de que la regulación acerca de la IA en los Estados Unidos, aún está instalada sobre un terreno fangoso, en construcción.

Desde nuestro punto de vista, así podríamos resumir los planteamientos de la orden ejecutiva sobre IA

- Frenará leyes estatales que entren en conflicto con la política federal en proceso de definición, con la colaboración del Congreso. (Contar con “una norma nacional mínimamente gravosa, no 50 normas estatales discordantes”).

- Creará un grupo de trabajo para abordar litigios de IA. (Entendemos como litigios, sólo aquellos que surjan de la impugnación de las propias leyes estatales de IA).

- Evaluará las leyes estatales de IA. (Para ver qué leyes contienen modelos de IA que obligan a desarrolladores a divulgar información, violando la Primera Enmienda —sobre libertades fundamentales— o alguna otra disposición de la Constitución).

- Vinculará el desarrollo de la IA al Programa de Acceso e Implementación Equitativa de Banda Ancha. Buscará garantizar crecimiento de aplicaciones de IA, pero asociadas con fomento de redes de alta velocidad. Y con ello procurará conectividad universal de alta velocidad.

¿Cuál será el incentivo para los gobernadores de los estados?

La orden anuncia la publicación de un aviso de política, que ayudará a identificar aquellos estados que serán elegibles para financiar sus redes de alta velocidad.

Un nuevo protagonista: el Asesor Especial de IA y Cripto

En cada una de las secciones del proceso de concepción, evaluación y puesta en marcha de la orden ejecutiva, se reserva gran intervención para el Asesor Especial de IA y Cripto.

Funge como conductor de la política de AI. Pero también preside el Consejo Presidencial de asesores para la Ciencia y la Tecnología de los Estados Unidos.

Es claro que se percibe la mano del presidente Trump en esta orden ejecutiva.

Pero, sin duda, se aprecia también la mano del Asesor Especial de IA y Cripto. Esta función fue creada por el titular del Ejecutivo al tomar posesión del cargo, a principios de diciembre de 2024.

¿Quién es el Asesor Especial de IA y Cripto?

Vamos a enmarcarlo como uno de los tres empresarios de tecnología republicanos, que en este periodo han aparecido en primera fila.

Los tres fueron fundadores de PayPal. Han sido conocidos como ThePayPal Mafia, estigmatizados a raíz del artículo que publicó Jeffrey M. O’Brien en la revista Fortune, el 26 de noviembre de 2007.

En dicho texto se aborda el itinerario afortunado de los fundadores de PayPal.

Los tres nacieron entre 1967 y 1972. Y los tres emigraron en su niñez o adolescencia hacia los Estados Unidos.

Vamos a referirnos en particular al Zar de IA y Cripto, como se conoce a David O. Sacks (Ciudad del Cabo, Sudáfrica, 1972). Pero no sin dejar de mencionar a los otros dos: Elon Musk (Pretoria, Sudáfrica, 1971) y Peter Thiel (Alemania, 1967).

David Sacks y la IA

Abundemos un poco sobre el Asesor Especial de IA y Cripto, David Sacks.

Desde su natal Ciudad del Cabo, Sudáfrica, su familia lo llevó, a los cinco años de edad, hasta Tennesse.

Con el paso de los años, egresaría de Stanford (Economía) y de la Universidad de Chicago (Derecho).

No sólo llegaría a ser un exitoso inversionista en PayPal, sino que ha impulsado diversas empresas tecnológicas, como SpaceX, Uber, Airbnb y Reddit, entre otras.

Es considerado unángel inversor de Silicon Valley, y hoy dirige la compañía de capital de riesgo Craft Ventures y es fundador de otra de software para aeronavegación y defensa, llamada Palantir.

Es uno de los empresarios del sector que se ha caracterizado por no rehuir la discusión sobre temas diversos de economía, política y desarrollo.

Se espera que no siga el camino inaugurado por Elon Musk, quien inició al frente de DOGE (el Departamento de Eficiencia Gubernamental), para renunciar a los pocos meses.

Todo parece indicar que Sacks será el personaje clave en este propósito concentrador del presidente Trump.

Los mayores personajes pro IA y pro Cripto

AI Diplomacy pic.twitter.com/DPvgVun50r

— David Sacks (@DavidSacks) November 19, 2025

Imagen de X: A la izquierda figura David Sacks. Le siguen Marc Andreessen y Elon Musk. Marc Andressen fue cofundador de Netscape y de la compañía Andreessen Horowitz (con Ben Horowitz), de capital de riesgo, pionera en inversión en startups tecnológicas.

¿Qué implica para un país contar con un “marco regulatorio“?

En términos jurídicos, dotar a una actividad productiva o a un sector económico de un “marco regulatorio” (en este caso, la Inteligencia Artificial), implica desarrollar un proceso cuidadoso por etapas, que con frecuencia lleva más de un año.

Implica para el Congreso de un país democrático proporcionar certeza jurídica a la ciudadanía.

De acuerdo con todas las experiencias previas, ello se instrumenta a través de un andamiaje y una ruta de trabajo que debe incluir al menos cinco elementos.

- Un aparato normativo. Compuesto por leyes, reglamentos, decretos y resoluciones.

- Un aparato institucional. Compuesto por órganos o entidades, habilitados para instrumentar la regulación.

- Un conjunto de principios rectores. Que aseguren legalidad, proporcionalidad, transparencia, no discriminación y, sobre todo, seguridad jurídica.

- Un conjunto de objetivos regulatorios. Para efectos de inteligencia artificial, proteger lo que en México definimos como interés público, garantizar derechos a usuarios, fomentar competencia y procurar calidad de servicios.

- Un conjunto de mecanismos de aplicación. Condiciones para autorización, licenciamiento, fiscalización, sanciones y recursos administrativos.

¿Será necesario (o sostenible) un marco regulatorio para Inteligencia Artificial?

Es parte del debate actual. No hay una interpretación acabada.

La Inteligencia Artificial no es un sector específico.

Está compuesta, como el internet, por una multitud de actores y sectores concurrentes, además de congregar a numerosas vertientes tecnológicas convergentes.

Entre ellas, el internet de las cosas, la blockchain, la automatización de finanzas, los lenguajes de programación, el código cerrado o abierto, las redes de desarrollo, los centros de datos.

Influyen en el debate actual, sobre todo, las tendencias de Inteligencia Artificial que animan un desenvolvimiento no lineal.

¿A qué nos referimos cuando señalamos tendencias de IA que animan un desenvolvimiento no lineal?

Nos referimos en particular a las tendencias que marcan diversos actores que se caracterizan por su permanente recomposición e integración.

Dichas tendencias son impulsadas, por ejemplo, por los siguientes actores:

- la industria de semiconductores (con predominio privado);

- la supercomputación (con predominio público);

- los centros de datos (con predominio privado y de concentración previsible);

- los precursores de LLM (con predominio privado, con la excepción suiza que analizamos de Apertus);

- los actores económicos tradicionales de hardware (con predominio privado, estadounidense en esencia);

- los gobiernos de los Estados nacionales, sus Congresos, sus universidades, sus centros de investigación científica y tecnológica, sus organismos empresariales y su opinión pública;

- los espacios virtuales de programación cada vez más amigables y públicos, en torno a Github, pero también auxiliados por Discord y, como siempre, por Reddit;

- Los lenguajes de programación con mayor enfoque, en seguridad y confiabilidad, con Rust, Go y TypeScript; en rendimiento y concurrencia, con Go, Rust y Elixir; en aplicaciones de IA y herramientas para las ciencias sociales, con Python; y

- los desarrolladores, los creadores de contenido, los usuarios demandantes de tecnologías dinámicas, entre muchos otros.

Balance regulatorio ante 2026

Nos parece claro que Europa, China y los Estados Unidos buscan el liderazgo en el desarrollo de la IA, pero cada región lo hace con estrategias y objetivos distintos.

Las tres mayores regiones geopolíticas del mundo, han publicado sus visiones distintivas, con objeto de influir en el rumbo futuro de la IA en el planeta.

Pero la verdad es que, en cada país, el marco regulatorio se encuentra aún en pleno desenvolvimiento.

Estimamos que la perspectiva normativa que han asumido las tres mayores regiones, dará un sello distintivo a la IA. Y ésta habrá de dinamizarse en 2026.

Primero fue China

El más serio esfuerzo chino por regular la inteligencia artificial en su territorio, proviene de las Medidas Provisionales para la Gestión de los Servicios de Inteligencia Artificial Generativa, que publicaron los Ministerios y Departamentos del Consejo de Estado, en julio de 2023.

La expectativa del mundo —que suelen traducir con fidelidad los LLM estadounidenses—, ofrecen una visión centralizadora y restrictiva de la regulación china.

Pero lo cierto es que también China mantiene una regulación en desarrollo. Permanece influida por las dos visiones de regulación dominantes. Una formal y precavida (la europea). Otra pretendidamente abierta y liberal, pero concentrada en la visión del Ejecutivo (la estadounidense).

¿Qué dice Claude acerca del marco regulatorio de China?

La respuesta que nos ofrece Claude (Anthropic) parece una buena síntesis de la versión que predomina en las fuentes hemerográficas occidentales.

Pero pensamos que la realidad admite muchísimos matices.

Esta es la opinión de Claude:

“*China: Control estatal, estabilidad social y competitividad*

China ha sido pionera en regular aspectos específicos de la IA, mediante múltiples regulaciones desde 2021 (algoritmos de recomendación, deepfakes, IA generativa).

Sus preocupaciones son:

– *Estabilidad del régimen*: prevenir que la IA desafíe el control del Partido Comunista o genere contenido subversivo.

– *Valores socialistas*: alineación de sistemas de IA con la ideología oficial.

– *Seguridad de datos*: soberanía digital y control sobre información estratégica

– *Desarrollo controlado*: fomentar innovación pero bajo supervisión estatal estricta.

– *Dominio tecnológico global*: alcanzar liderazgo mundial en IA para 2030.

El modelo chino integra la regulación de IA en su sistema más amplio de gobernanza autoritaria, donde la tecnología debe servir a objetivos estatales.” [Fuente: Claude, Sonnet 4.5].

¿Sinceridad de Claude?

Agradecemos la sinceridad de Claude.

Por nuestra parte, creemos que es probable que, en China, luego del sorpresivo y afortunado arribo del LLM DeepSeek, en el amanecer de 2025, se pueda otorgar cierta flexibililidad en la perspectiva regulatoria.

Estimamos que, para 2026, existen ya numerosos incentivos para que China asuma un camino de adaptación al nuevo ambiente (sobre todo, por razones tecnológicas y comerciales).

Esos incentivos los podrían llevar a compatibilizar, en lo posible, sus criterios regulatorios mayores con las regiones más dinámicas del comercio en Occidente.

No podemos seguir juzgando el futuro de la IA en China, sólo con base en la regulación de hace más de cinco años:

- la Ley de Ciberseguridad de la República Popular China (2017),

- la Ley de Seguridad de Datos (2021); y

- la Ley de Protección de Información Personal(2021).

¿Qué perspectiva mantiene la regulación europea?

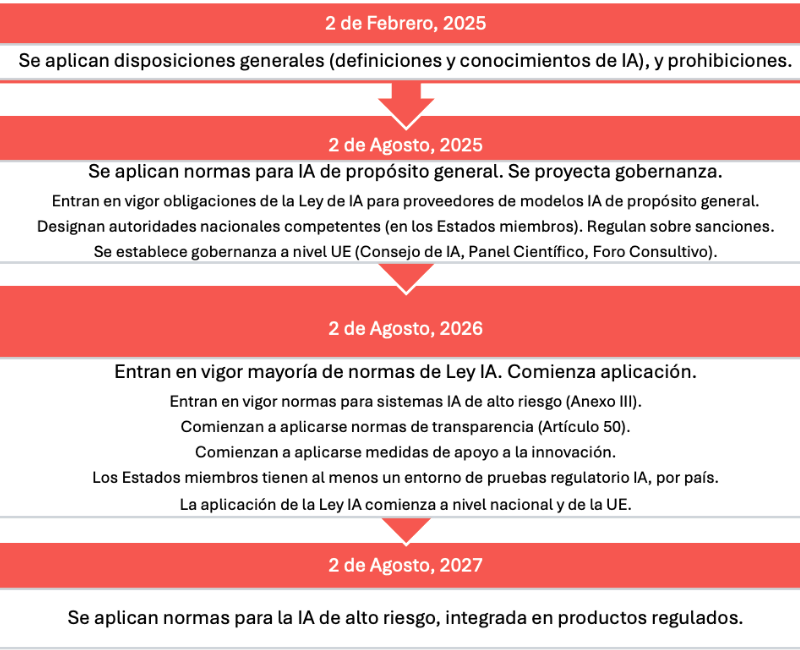

El reglamento de IA publicado por la Unión Europea se postula como “el primer marco jurídico global en materia de IA en todo el mundo”. (Ver: Regulationof the European Parliament and of the Council of 13 June 2024).

Es un documento marco, que establece un abanico documental. En éste figuran cuatro componentes complementarios:

- la plataforma de información única de la Ley de IA,

- el Plan de Acción para el Continente en materia de IA,

- el paquete de innovación en materia de IA; y

- las fábricas de IA.

Recogemos lo relevante de su noción central, basada en la definición de que está enfocada en el ser humano. Es decir, busca priorizar la garantía de la seguridad y los derechos fundamentales.

Con ello, se espera perseverar en la adopción, la inversión y la innovación de la IA.

La ruta del “Enfoque europeo de Inteligencia Artificial”.

El acento europeo de prevención

Es un documento con evidentes propósitos de contención, ante los efectos del despliegue de la inteligencia artificial, luego de su aparición vigorosa a finales de 2022 (ante la oleada que creó OpenAi, con ChatGPT 3.5).

El tiempo dirá… El énfasis europeo que apreciamos en los derechos fundamentales y en la protección ciudadana, podría llegar a tocar linderos de lo tutelar.

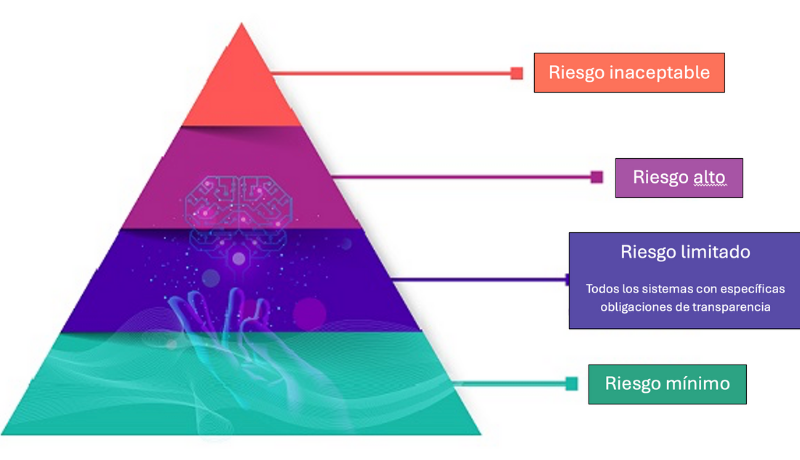

La IA vista como un riesgo

En el plano programático acentúa la noción del riesgo, como un componente central de la Inteligencia Artificial.

Desde nuestro punto de vista, no es que el riesgo no sea un componente de la IA. ¿Pero es el central?

Diríase, la perspectiva europea toma como punto de partida el enfoque precautorio y normativo en cuatro niveles de riesgo, que parece no colocar con la relevancia suficiente a la práxis de innovación.

- Prohibiciones categóricas: estigmatización social; manipulación subliminal y reconocimiento facial en tiempo real.

- Rendición de cuentas: obligaciones para desarrolladores y emisores.

- Transparencia: explicitar eventual afectación en decisiones automatizadas.

- Derechos: privacidad, dignidad humana, no discriminación.

Enfoque europeo del riesgo(cuatro niveles para sistemas de IA). Configurar el futuro digital de Europa.

Definición de riesgo europeo en los modelos IA

Sobre la noción de riesgo, la supervisión europea acerca de los sistemas de IA va desde lo inaceptable (prohibido), hasta el riesgo limitado o mínimo.

Éstos últimos son los reservados para los sistemas llamados GPAI (modelos IA de Propósito General)

La Ley IA europea define como modelos GPAI a los sistemas de inteligencia artificial que son capaces de realizar una amplia gama de tareas.

Debe decirse que algunos de los mayores impulsores de modelos GPAI ya se han comprometido con el Código de Prácticas de GPAI de la Ley IA europea, como son los casos de OpenAI, Anthropic, Google y Mistral.

Pero abundemos ahora sobre aquellos sistemas que se consideran inaceptables o prohibidos por la Ley IA de la Unión Europea. (Artículo 5).

Bien vista, la capa superior de la pirámide de prohibiciones de la Ley IA por momentos nos parece como una extensión tardía de alguna regulación sobre la Web3.

Sistemas de IA prohibidos por la Unión Europea

- Cuando existan técnicas subliminales o engañosas, que busquen distorsionar el comportamiento individual y perjudicar la toma de decisiones de las personas.

- Cuando se exploten vulnerabilidades, derivadas de la edad, la discapacidad o la condición socioeconómica.

- Cuando se operen sistemas de categorización biométrica, que infieran atributos sensibles (raza, opiniones políticas, afiliación sindical, creencias religiosas, vida u orientación sexual), con excepciones de aplicación.

- Cuando se apliquen sistemas de puntuación social, encaminados a clasificar a individuos o grupos según comportamientos sociales o rasgos personales.

- Cuando el sistema pretenda evaluar el riesgo de que un individuo cometa delitos, con base en perfiles o rasgos de personalidad (con excepciones de aplicación).

- Cuando el sistema compile bases de datos de reconocimiento facial, con imágenes faciales de Internet o de grabaciones.

- Cuando el sistema infiera emociones en lugares de trabajo o centros educativos, con excepción de justificación médica o de seguridad.

- Cuando el sistema busque identificación biométrica remota en tiempo real, en espacios de acceso público para las fuerzas de seguridad, con la excepción de la búsqueda de personas desaparecidas, víctimas de secuestros y víctimas de trata o explotación sexual. Así también, cuando se trate de prevenir una amenaza o de identificar sospechosos de otros delitos graves.

¿En qué momento regulatorio de la IA se encuentra el mundo?

En resumen, creemos que la regulación en los distintos países aún es temprana. Navega por aguas inquietas:

- entre el espíritu de excesiva contención de la Inteligencia Artifical;

- entre la costumbre del poder, para concentrar su fomento y desarrollo; y

- entre el incipiente diseño macro, en espera del despliegue de variables que permitan articular una normatividad realista y compartida. Una regulación integrada que asegure, al mismo tiempo, derechos de las personas y crecimiento de la innovación.

¿Cuál es tu visión acerca de las tendencias normativas en marcha ?

Fuentes:

Endal, Oystein; Andrea Vcric; Sidsel Nag; Nick Malter; y Daylan Araz, “Modificación de la IA con arreglo a la Ley de IA de la UE: Lecciones prácticas sobre clasificación y cumplimiento”, en EU Artificial Intelligence Act, 5 de Noviembre, 2025.

EU Artificial Intelligence Act, “Resumen de alto nivel de la Ley AI”, 27 Feb, 2024 (Actualizado el 30 de mayo, de acuerdo con la versión Corrigendum de la Ley AI).

Filipova, I. A., “Legal Regulation of Artificial Intelligence: Experience of China”, Journal of Digital Technologies and Law, Vol. 2, núm.1, 2024.

Official Journal of the European Union, “Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024”, 12 de julio, 2024.

Trump, Donald, “Statement by President-elect Donald J. Trump Announcing the Appointment of David O. Sacks as White House A.I. & Crypto Czar“, 5 de Diciembre, 2024.

Zhang, Lu y Mimi Zou, “Navigating China’s regulatory approach to generative artificial intelligence and large language models”, publicado en línea por Cambridge University Press, 6 de enero, 2025.

Imagen de la Portada: generada por Gemini 3 Pro.

Comentario

Gracias Carlos por la compilación. de estas tendencias regulatorias de la IA.