PolifonIA.org | Carlos Macías. Ahora que estamos en la antesala de computación cuántica, conviene identificar las etapas de evolución y los rasgos esenciales de las supercomputadoras.

Imaginar la etapa post cuántica.

En días recientes, la Secretaría de Ciencia, Humanidades, Tecnología e Innovación (Secihti) de México ha firmado unmemorándum de entendimientoque conlleva el inicio de la construcción de la “Supercomputadora más grande de América Latina”.

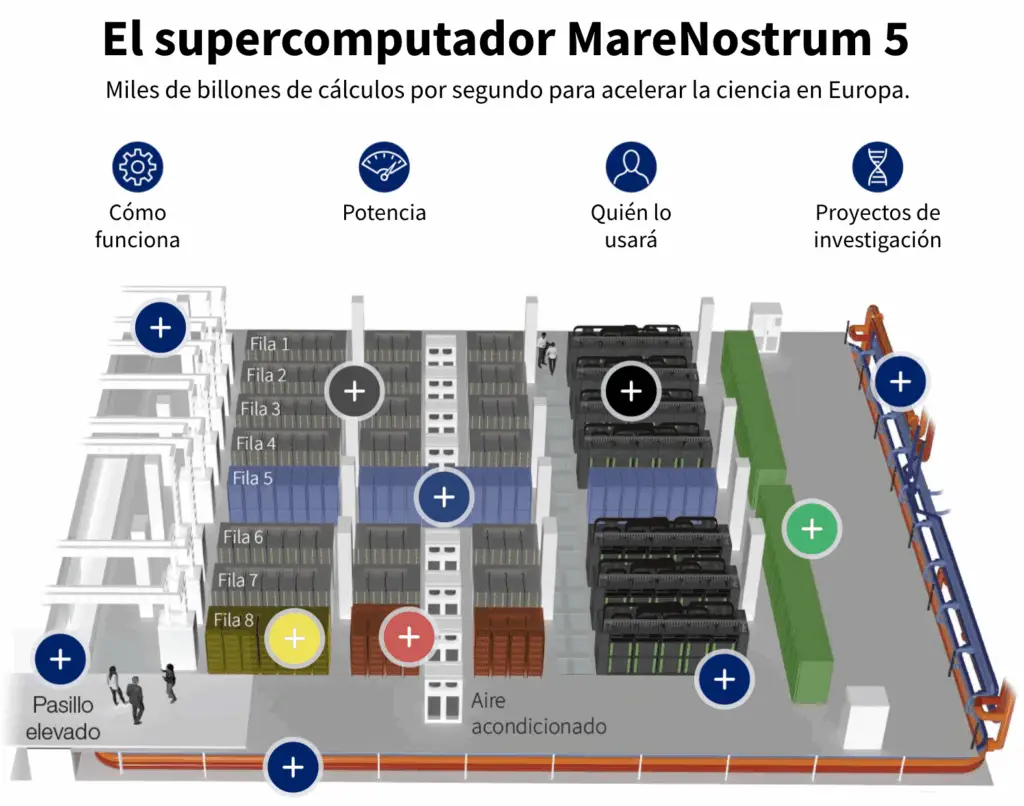

El anuncio colocó en contexto un proyecto simultáneo, el del Centro Mexicano de Supercómputo. Un proyecto por precisar aún, que podría compartirse con el Centro de Supercómputo de Barcelona (BSC), que alberga el MareNostrum 5, una de las máquinas científicas más poderosas de Europa.

Conviene señalar queel MareNostrum 5 posee una capacidad para procesar de 314 petaflops, y arrancó en 2023.

En las siguientes líneas, intentaremos dimensionar este anuncio.

¿Cómo definimos a las supercomputadoras?

Una supercomputadora tiene como propósito efectuar procesamiento de cálculos enormes y de alta complejidad. Cuando varias computadoras participan para resolver un cálculo específico, el proceso de concurrencia se define como Computación de Alto Rendimiento (HPC en inglés).

Como el objetivo mayor que plantea la supercomputación es resolver problemas de alta complejidad, resulta conveniente establecer los alcances que tienen las supercomputadoras en el contexto de las estaciones del progreso.

Una supercomputadora tiene como fundamento la lógica digital que nos legaron los matemáticos del pasado, y se inspira en la física clásica. Procesa en bits, lo puede hacer en 0 ó en 1, y puede procesar con paralelismo, al ser reforzada con más equipos.

Es decir, la construcción de una supercomputadora hace acopio masivo de procesadores de marcas similares a las que llevan nuestras PCs (aunque de modelos de mayor sofisticación), pero que tienen el atributo de poder actuar en paralelo.

¿Y cuál es la diferencia con la computación cuántica?

La computación cuántica se inspira en la mecánica cuántica y puede trabajar más allá del paralelismo, digamos de modo entretejido, con cúbits, porque están habilitadas para incluir no sólo 0 ó 1, sino también ambos.

En nuestros dias, la computación cuántica avanza a pasos acelerados (véase nuestrareciente nota).

Avanza, por ejemplo, en la posibilidad de romper los métodos de cifrado actuales. El estándar actual de cifrado es SHA-2, debido a que el SHA-3 aún ralentiza el procesamiento en los equipos de cómputo públicos.

Así por ejemplo, el bitcoin fue programado en 2009 con el SHA-256, para crear sus largas direcciones. Pero, sobre todo, para asegurar el mecanismo en red para procesar los bloques de la cadena (blockchain). Véase nuestra nota al respecto, de 2018.

Es evidente que en la criptografía veremos próximamente, antes de 2030, un reforzamiento de los códigos empleados para la minería, y así anticiparse a la resolución de problemas que serán capaces de dilucidar las computadoras cuánticas. Es necesario para ofrecer seguridad a las propias direcciones de wallets, lo mismo que para asegurar la generación de nuevos bloques de la cadena, pues se estima que el último satoshi por acuñar rondará por el año 2140.

Ante el avance de la computación cuántica tiene sentido, entonces, que se hable ya de la criprografía post-cuántica. En finanzas, en nuestros correos electrónicos, en nuestros documentos de identidad y en nuestras contraseñas, más allá del hasta hoy seguro autenticador 2FA.

¿Podrán convivir las supercomputadoras con las computadoras cuánticas?

Esta es una pregunta pertinente para los chats de OpenAI o de cualquier LLM a elegir.

La respuesta predominante confluye en la idea de que probablemente veremos en el futuro un modelo de computación híbrida:

Las supercomputadoras -razona Gemini 3- seguirán siendo necesarias para el llamado cálculo cotidiano, la gestión de grandes bases de datos y el entrenamiento masivo de modelos de IA.

Las computadoras cuánticas, en cambio, serán un género de aceleradores para enfrentar las tareas más difíciles y específicas en los cuellos de botella. Justo esos que las supercomputadoras no puedan resolver en un tiempo razonable.

¿Cómo se mide la capacidad de una supercomputadora?

La medición se hace mediante flops (Operaciones de Punto Flotante por Segundo, en español), que se refiere a las operaciones potenciales para ser realizadas en el tiempo indicado.

Los petaflops tasan la velocidad de procesamiento que puede llegar a tener una supercomputadora, en el equivalente de mil billones de flops (1015). Un petaflop = mil billones de flops. La IBM calcula que “las supercomputadoras pueden tener un millón de veces más potencia de procesamiento que la computadora portátil más rápida.”

Hoy en día, en el mundo existen tres o cuatro supercomputadoras que superan la capacidad de mil petaflops. La número uno, sin duda, es El Capitán, que se encuentra en un laboratorio ubicado en California, gestionado por el Departamento de Energía de los Estados Unidos, mismo que referiremos lineas abajo.

En el standard que probablemente habrá en unos cinco años, la capacidad de un petaflop podría predominar. Es decir, mil billones de flops. Tal es el caso hoy de las tres instalaciones de equipos de computo líderes, que comentaremos líneas abajo (aparte de EL Capitán, en California, y dos en Tennessee).

Algo de historia, para enmarcar.

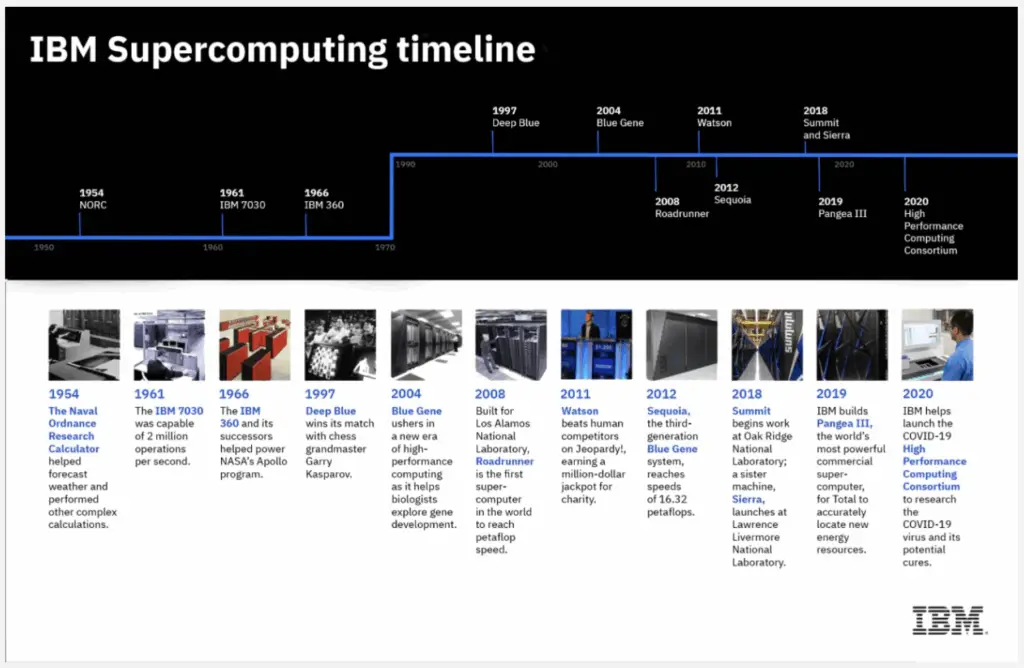

Probablemente, el origen de las supercomputadoras deba establecerse en 1940, de la mano de la colaboración bélica entre los Aliados.

Los ingenieros británicos que trabajaron para decodificar mensajes alemanes se concentraron en la instalación militar de Bletchley Park (hoy museo de cómputo), ubicada en el sureste de Gran Bretaña, en el condado de Buckinghamshire.

Justo Alan Turing solicitó apoyo alequipo británico, en particular al ingeniero Tommy Flowers, para crear un dispositivo que ayudara a decodificar los mensajes teutones. El primer intento no fructífico, pero el segundo resultaría decisivo.

La máquina inglesa Colossus.

Los alemanes contaban con varios modelos de máquinas de código ultrasecreto, pero quizá la más conocida fue la llamada Enigma. Otro modelo, más grande y complejo fue la máquina Lorenz.

Aún en nuestros días existen varios ejemplares de Lorenz, porque según reportó Interesting Engineering, en el año 2016 se vendió una Lorenz en ebay por 14 dólares, aunque con un motor faltante.

El equipo de Flowers construyó en 1943 una nueva máquina que cobraría la mayor relevancia. Se trató de la Colossus, con 1800 válvulas térmicas. Capaz de leer cerca de 5000 caracteres por minuto. Ante la relativa limitación de la máquina previa denominada Heath Robinson. Ésta última había sido diseñada centralmente por un compañero de Flowers, Max Newman, y sólo leía 1000 caracteres.

Supercomputación: fin de la guerra fría.

Imagina el inicio de la década de 1960. De la mano con la IBM y con Sperry Rand (quizá recuerdes esa marca, si eres baby boomer), al empezarse a volver más popular hablar de supercomputadoras.

La IBM produjo el modelo 7030 Stretch. Sperry Rand creó el modelo UNIVAC LARC. Este despliegue de supercomputadoras corrió en paralelo al fin de la guerra fría y, como se entenderá, fue acompañado de propósitos militares. De modo que cualquiera pensaría que estas supercomputadoras sólo estuvieron en manos del gobierno estadounidense, pero no.

La empresa Control Data Corporation (CDC), por ejemplo, creó el modelo 6600, que diseñó el ingeniero Seymour Cray. De acuerdo con la BM, dicho modelo resultó un hit comercial: “se considera laprimera supercomputadora comercial exitosa”. No debe extrañar, por tanto, que haya correspondido a la IBM liderar la producción de equipos a partir de la década de 1970.

¿Quiénes son los mayores actores de hoy?

Las mayores fabricantes de supercomputadoras en el mundo, son las compañías conocidas del sector. En este orden, las estadounidenses HP, IBM, DELL. La japonesa Fujitsu. La china Lenovo (que en 2004 compró la división de computadoras personales de IBM). Más recientemente, Huawei.

La mayoría de las más potentes supercomputadoras del mundo se encuentran en los Estados Unidos, y son abastecidas por las primeras.

Entre 2023 y 2024 se construyó la supercomputadora El Capitán, por parte del Lawrence Livermore National Laboratory, ubicado en California. Sus operaciones iniciaron en 2025.

El Capitán se ha ganado el título por tener la mayor capacidad en el mundo. Posee una ejecución de 1,742 petaflops, es decir 1.742 exaflops, muy por encima de sus rivales. Incluye componentes múltiples, con predominancia de AMD. Las instalaciones pertenecen al Departamento de Energía estadounidense.

La segunda es de otro laboratorio público, el Oak Ridge National Laboratory, de Tennessee. Dicho equipo fue construido por un discreto actor dominante (Cray). Cuarto lugar como constructor de supercomputadoras en el mundo: la compañía de largo historial, creada por Seymour Cray.

Ese equipo fue colocado en 2022 en el National Center for Computational Sciences, en Oak Ridge National Laboratories, en Tennessee, con un desempeño de 1,353 petaflops (1.353 exaflops), también con una mayoría de semiconductores fabricados por AMD.

La tercera se ubica en el Argonne National Laboratory, en Illinois, con una ejecución de 1,012 petaflops (1.012 exaflops), pero con componentes de Intel.

En cuarto figura Microsoft Azure, se diría instalada en la nube, con una capacidad de 561 petaflops, también con preminencia de Intel.

Curiosamente, la mayor compañía de energía italiana se ubica en el quinto lugar. Es Eni. Cuenta con su Green Data Center Eni, en Ferrera Erbognone. Alcanza un desempeño de 477.9 petaflops, con procesadores de AMD.

Y de modo consecutivo, Fugaku de Japón (con 442 pentaflops) y ALPS, de Lugano, Suiza, con desempeño de 270 petaflops.

Colofón.

La supercomputadora del Centrode Supercómputo de Barcelona (CSB), la MareNostrum 5, se construyó con el respaldo de la compañía Eviden (Atos). Eviden es una multinacional europea, especializada en tecnologías de la información.

El también llamado Barcelona Supercomputing Center (BSC) es un consorcio público formado por el Gobierno de España, la Generalitat de Catalunya y la Universitat Politécnica de Catalunya.

La primera versión de MareNostrum se construyó en 2004; inició con una capacidad acorde a sus propósitos, sin superar un petaflop. Pero su avance ha sido consistente.

Su versión más reciente, la MareNostrum 5, que fue inaugurada en diciembre de 2023 tiene un respetable desempeño de 314 petaflops, y digamos que a finales de 2025 se ubica ya entre las 12-15 supercomputadoras con mayor capacidad en el mundo.

MareNostrum 5 contó con la colaboración de Lenovo al ser instalada y equipada, y con la de Intel y Nvidia, en lo relativo a la dotación de semiconductores.

De modo que la supercomputadora anunciada para construirse en México tiene fundamentos, pero entendemos que deberá afrontar los consabidos azares presupuestarios y las disyuntivas técnicas y tecnológicas del caso.

No tiene por qué comprometerse su conclusión en dos años (2025 y 2026). Estos proyectos requieren paso seguro y programado, si se piensa en la proyección tecnológica del país.

Las tareas que figuran en primer plano para Cloatlicue, como retos de cálculo para el futuro inmediato, son: modelado de clima, simulaciones, diseño, dinámica y procesamiento de bases de datos masivas para modelos de IA (como el entrenamiento de un LLM), entre otras capacidades.

Se decidió llamarla Coatlicue, que fue la madre mexica de Huitzilopochtli, dios de la guerra, y de Coyolxauhqui, diosa de la luna. Se asume un aura centralista, a partir del célebre triángulo dramático entre ellos, que cuenta con representación pétrea.

No nos hubiera disgustado que se llamara Nik, que fue el concepto matemático maya, a la vez que una flor, para representar al cero, dentro de su reconocido e innnovador sistema de numeración vigesimal.

¿Qué piensas del anuncio de la construcción de una supercomputadora en México?

Fuentes: IBM, “¿Qué es es la supercomputación?”, s.f. LiveScience, “The 9 most powerful supercomputers in the world right now”, 20 de enero, 2025. Interesting Engineering, “Tommy Flowers: The Man Who Built Colossus”, 21 de mayo, 2025.

Imagen de portada: Gemini 3.